今天,分享一篇3D芯片创新,颠覆性视觉革命如何实现?| 华映family,希望以下3D芯片创新,颠覆性视觉革命如何实现?| 华映family的内容对您有用。

来源:华映资本

2015年春天,洛杉矶的中国大剧院冠盖云集,又是一年一度的奥斯卡颁奖礼,这一年美轮美奂的“布达佩斯大饭店”输给了“鸟人”。同样是这一届奥斯卡,一家芯片企业,美国德州仪器公司(Texas Instrument)也获得了奥斯卡技术奖,奖项是数字光处理DLP(Digital Light Processing)芯片。

这是一项史诗性的技术,从1987年发明迄今,直接把人类带进超大屏幕数字影像时代,从0到数百亿美金快速崛起,垄断90%市场。每一天,全世界数以千万的办公室,学校,家庭和数十亿的人都在使用这一项技术。2023年,当人工智能的大潮汹涌而来,基于DLP技术的3D影像和3D增强现实显示,在机器人视觉和元宇宙应用中再次卡位,历经36年后,又一次站在了历史的潮头!

3D视觉极大可能是自百年前,人类发明黑白胶片以来,再一次颠覆性的视觉技术革命。然而,作为一家美国技术企业,TI占据了重大的先发优势。在美国一浪接一浪的技术压制和制裁下,基础层的3D视觉芯片,或者说,中国机器人的“眼睛”会不会再次被“美国卡脖子”?

我们是一群心怀理想的芯片技术小球,过去的10年间,踩了很多坑,爬了很多山,我们希望追赶上TI这个伟大的企业,至少x在3D视觉和先进光学领域,我们已经看到了巨人的背影。在这个系列中,我们很想分享一下我们学到的东西。这一项技术为何重要?如何从底层技术原理上,实现“me better”而非me too的超越?作为一个“硬科技”企业,从技术到产品,我们已经打通哪些关键的技术点?

本文作者是中科融合创始人王旭光,中科融合成立于2018年,孵化于中科院苏州纳米所,以MEMS结构光3D感知模组切入3D成像市场,提供3D视觉传感器解决方案,可用于机器人、医疗等领域。公司自主研发了3D视觉智能传感模组,具备MEMS精密光学、精度3D与人工智能算法、高性能低功耗3D SoC算力芯片等产品。华映资本是中科融合的早期投资方,华映长期看好中科融合的未来发展,期待和公司共同努力,加速国产技术的智能化进程。

介绍:从人类立体视觉到机器立体视觉

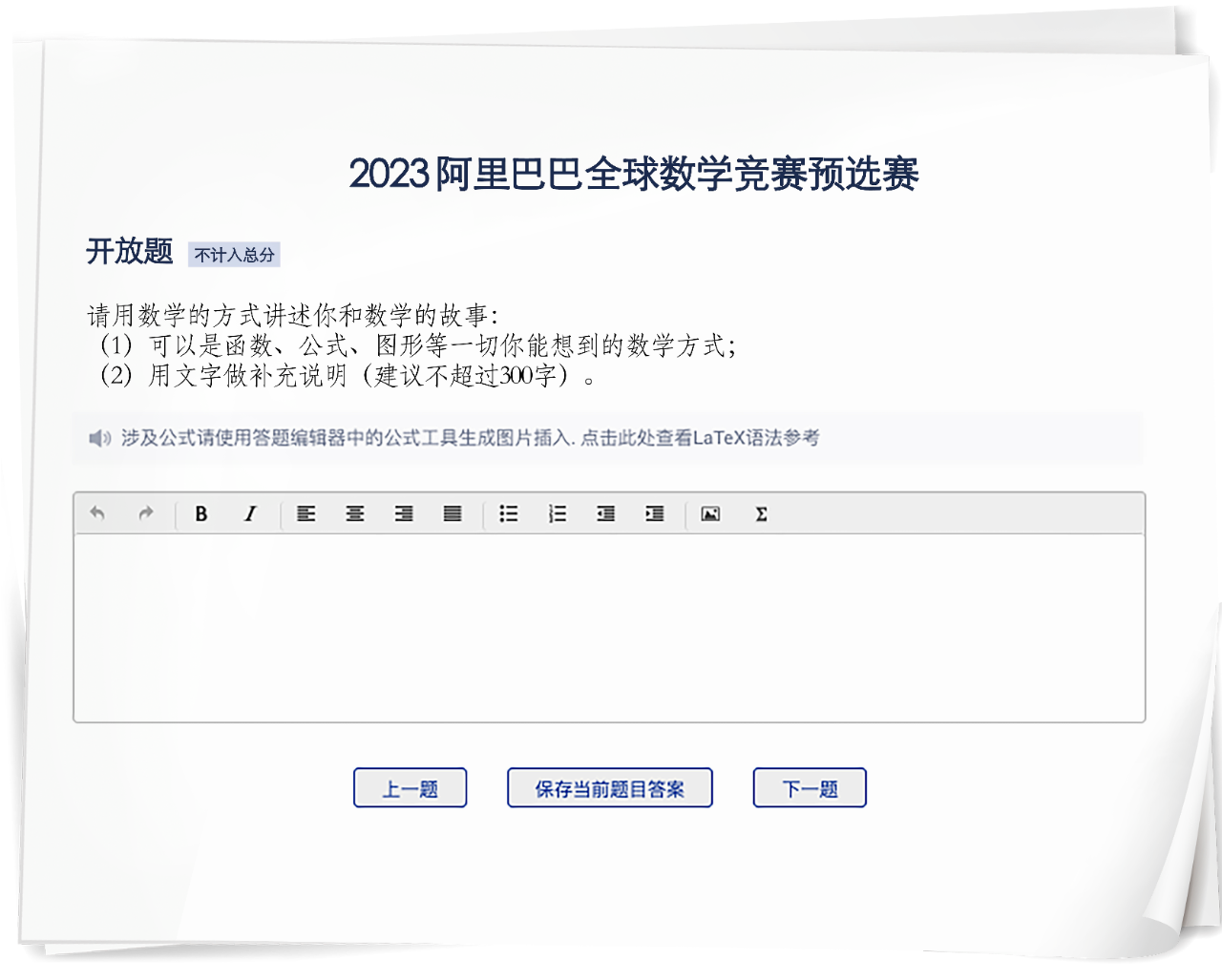

3D立体视觉是我们人眼与生俱来的能力,为人类获取高达80%的外界信息。然而从人类发明轮子以来数千年,机器都缺乏和人一样的3D视觉能力!直到近10年,随着底层元器件、核心算法等技术的快速发展,应用于工业机器人的视觉引导,物流的拆码垛,医疗的体征扫描,服务机器人的自动避障,自动驾驶的激光雷达,以及混合与增强现实所需高沉浸感的3D建模、3D打印,都对3D视觉提出了大量的需求。根据国际知名机构Yole的预计,这一市场在2026年接近1000亿元人民币规模,年增速接近15%。

3D视觉硬件具有接近1000亿美金的市场规模,年均两位数增长

为什么机器也需要3D立体视觉?电视里面宣传的机器人,不是十几年前已经都可以组装汽车了吗?没错,当大街上的汽车都是一模一样的桑塔纳,捷达的时代,机器人不需要3D视觉,甚至都不需要视觉。这个时代,所有的车一模一样,所有的零部件一模一样,与其说是机器人,更加准确的描述,是“机器臂”。对这些机器臂唯一的要求,就是千万次的重复,每一次重复同一套“规定”动作,运动到同一个“固定”位置。进入21世纪,个性化产品成为时代的主流,生产线必须具备多品种,小批量快速迭代能力,“柔性生产”成为“智能制造”的核心需求。因此,“机器”必须和人一样,要有一双“眼睛”,看得见,看得清,看得懂。这双“3D眼睛”,推动“机器臂”到“机器人”迈出了至关重要的一步!

3D视觉进入了高速发展期,在3D建模,自动驾驶和增强现实有广泛的应用前景

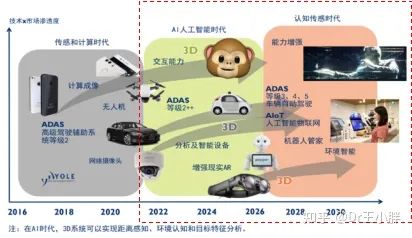

人类的立体视觉是如何实现的?把你的食指放在你的鼻子正前方大概30cm的地方,双眼直视前方,特别是注意食指后面的背景物体,你看到了什么?然后先闭上左眼,右眼睁开。再闭上右眼,左眼睁开。你将会明显注意到,食指后面的物体,似乎在“移动”。这个移动,称为“视差”。人类的3D视觉是通过双眼的视差(disparity)来实现的。双眼的视差是指同一个物体在两只眼睛的视网膜上投影的位置不同,这种差异可以让大脑判断物体距离自己的远近。正是由于这个视差的存在,大脑中会形成对于空间的立体感知。如果我们想喝水,看到桌子上的杯子,眼睛不仅告诉我们桌子上杯子在哪里,还会配合大脑,告知我们杯子的把手在哪里,什么形状,距离多远,大脑就会控制我们的手臂去抓住把手“合适”的位置,而如果抓住杯子边缘,是很难抓起杯子的。这就是人类的3D感知,识别,判断,行动的全流程,机器同样需要“3D的眼”和“3D的脑”。

人眼和机器的3D感知,都需要光学和处理两个重要组成部分

工业,医疗,军工是最早使用3D机器视觉的领域,根据Yole的估计,仅仅是这些领域,就有将近50亿美金的3D视觉硬件需求!而具有高精度,高分辨的DLP技术,目前是这一领域的王者。基于DLP技术的3D视觉传感器,可以引导大型机器臂,在数米外,准确测量达到毫米级别的零部件精度,控制6个自由度运动和抓取动作。可以引导医生进行精密的手术,在患者体内极其狭窄空间内,完成无创微创的操控。也可以在精密仪器设备的制造和反向工程研制中,完成具有微米数量级的3D建模。

3D机器视觉原理

机器的3D视觉原理,和人类的立体视觉原理,在本质上是相同的,不同的差异主要在于实现的机理,达到的精度和分辨率,以及有效的工作距离。用我们东北人话说,就是“眼神好不好”!

3D机器视觉,分为主动3D视觉和被动3D视觉。主动和被动是相对于传感器主体,如果传感器通过发射辅助光,投射到被观察的物体,与反射的环境光结合,称之为“主动视觉”,如果传感器仅仅通过环境光反射后,观察视差结果,获得3D信息,称之为“被动视觉”。简单地理解,如果黑夜中我们使用“手电筒”照亮,就是主动视觉,而想要通过努力睁大眼睛,在微光中观察,就是被动视觉。从这个角度理解,主动视觉会比被动视觉具有更好的鲁棒性,更高的精度和分辨率。当然,由于主动视觉的引入,需要添加额外的辅助光投射装置,从而增加系统的复杂性和成本。

主动视觉根据3D测量的原理,又分为“飞行时间法”和“三角测距法”。

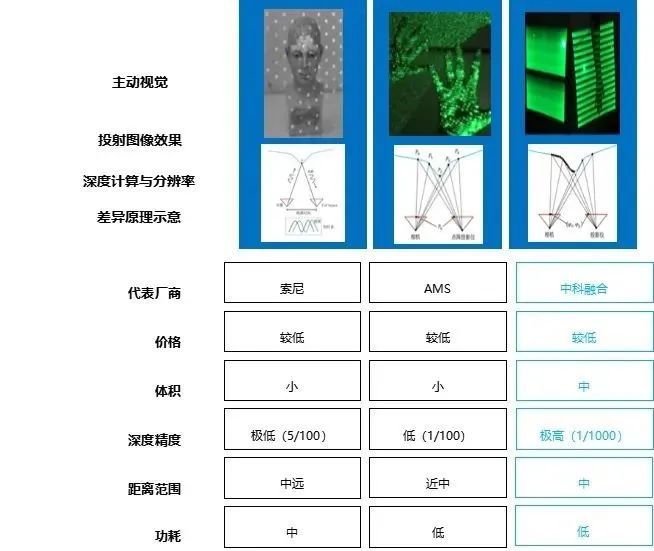

主流3D主动视觉工作原理比较,中科融合和TI的DLP都采用动态结构光,具有行业最高的分辨率和精度

飞行时间法:传感器发射的光子在被测试物体反射后,再次被传感器接收,那么距离就是飞行的时间和光速的乘积,考虑往返再除以2。听起来是不是很简单?然而光速是人类已知运动速度的天花板,飞行时间法达到高空间分辨率,需要极高的时间分辨率,通常毫米级空间分辨率,需要达到10皮秒级时间分辨率,或者说1秒钟的10^12分之一!这对于电路和器件的实现,提出了极高的挑战。此外综合考虑到真实环境的多路径反射,不同物体的反射率等现实因素。飞行时间法,目前往往用于分辨率在厘米以上的低空间分辨率与低平面分辨率的场景。主要应用于大尺度的测距,避障等应用,比如AGV,扫地机,服务机器人,智能驾驶,或者是体积粗测,镜头对焦等。

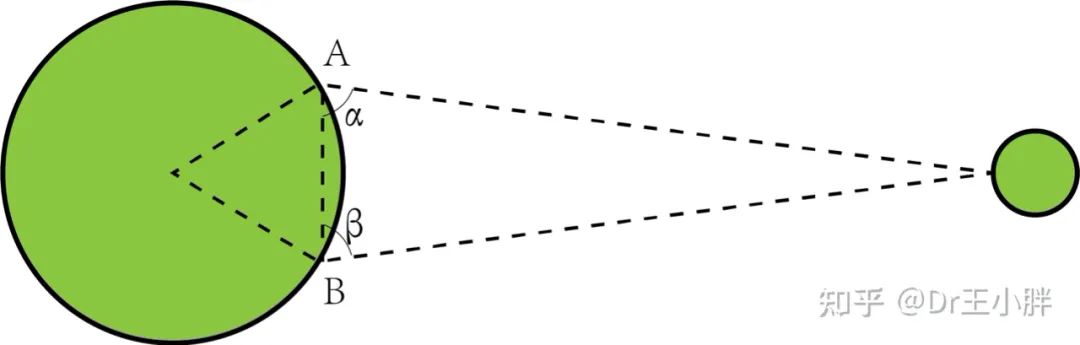

三角测量法,来自于基础的几何原理,是一种利用不同视点对同一物体的视差来测定距离的方法。对同一个物体,分别在两个点上进行观测,两条视线与两个点之间的连线可以形成一个三角形,根据这个三角形的已知连线长度和两个顶角的大小,就可以知道这个三角形的高,也就是物体距观察者的距离。早在1671年,两位法国天文学家为了测量地球与月球之间的距离,利用几乎位于子午线的柏林和好望角,测量计算出α、β的大小和两地之间的距离AB(基线),从而计算出了地球与月亮之间的距离约为385400km(如下图所示)。三角测量法的核心,是在空间建立被观察点与基线的三角关系。一旦这一三角形关系确立,被观察点的3D空间未知,是“计算”得出的“测量”结果,因此三角测量法的精度和分辨率,通常要大大高于飞行时间法。

三角测距法的基础原理

三角测距法的精度,来自于空间未知点,相对于已知底边的基线。但是,两个底角点的相对位置关系精度。这是如何获得的呢?“结构光”(structured light)方法就是这一领域的重大进展,顾名思义,结构光是为投射的主动光建立一个“结构”,这一结构含有一组已知的特征量。打个通俗的比方,这个结构,就像我们中学几何题中的“辅助线”。这条辅助线原本不存在,但是通过在几何形状中,添加这一线条,并且这一线条具有一些已知的信息,比如垂直于,平行于某个线段。就为系统中增添了信息,这一已知的信息,就成为解决未知问题的重要“参照物”。

结构光3D的实现和比较

常见的结构光特征包括散斑结构光,编码结构光,条纹光栅结构光等。苹果的iPhoneX大规模采用了基于散斑的结构光技术,Intel的Realsense采用了编码结构光技术和TOF技术,中科融合和美国德州仪器相同,采用了动态(条纹/编码)结构光技术。

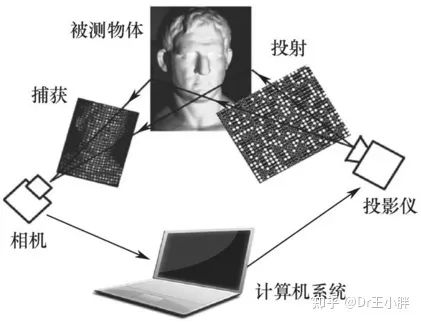

一个典型的结构光3D系统,包含“发射-接收-计算”三个核心组成部分。发射器主要功能是完成具有不同特征的结构光投射,接收器主要功能是同时记录,被观察物体以及结构光在被观察物体表面的变形,计算单元主要功能是将结构光的变形量,提取成为3D空间信息。

一个典型的结构光3D系统包含:发射的投影装置,捕获被测物体和因为3D轮廓而变形的结构光,以及提取3D的计算系统

发射器是结构光3D系统的核心部件。分辨率,空间精度,工作距离,重复精度等核心参数都与发射器的光学质量息息相关。DLP光机成为高精密3D光学领域的王者,主要得益于TI这一技术,无与伦比的光学投射质量,稳定性,以及规模量产的成熟度。

接收器在结构光系统中,可以采购货架产品的CMOS摄像头芯片和模组,主要关注的参数,是和发射的光源谱段适配的高灵敏CIS或者使用窄带滤光片。接收器的分辨率和投射器的结构光特征,具有一定的制约关系。由于数字化的CIS传感器的分辨率有限,如果投射器的特征远远高于分辨率,系统的分辨率瓶颈在于接收器,比如动态结构光。

计算单元,需要将CIS摄像头捕捉到的“被观测物体的2D(X-Y)信息”与“物体3D轮廓对结构光调制的3D(Z)信息”,进行解耦,基于外部环境参数和内部系统参数,匹配预先设计的特征,并且针对环境光反射,镜头畸变,高低动态等进行处理,最终计算得出一个同时具备“XYZ”信息的3D数据,通常使用“点云”(point cloud)格式。

目前典型的结构光系统,不同的企业和学术组织,尝试和设计了不同类型的特征方法。但主要包含散斑,编码,条纹等基本形态。散斑结构光技术,绝大部分采用DOE光学衍射和晶圆级准直光学器件。散斑结构光的DOE器件,由于基于二次衍射原理,衍射点的数量难以进一步提升,因此无法通过纳米加工技术,实现更高密度的特征,导致散斑的特征点规模有限,成为了系统的精度瓶颈。所以,无论接收端的相机精度如何提升,只能实现“多像素”的特征。但是,动态结构光,其深度信息来源于投射条纹的周期和相位的变化,而周期和相位的实现,来自投射器的光学谐振,近似于连续激光扫描,因此深度精度可以达到亚像素级别,是目前所有的结构光技术中,精度最高的。

总结

本文从人类的立体视觉原理介绍讲起,引入机器立体视觉的基本原理。对于飞行时间法和三角测距法的基本规则作了阐述,并且着重对于三角测距法的结构光展开,讲述了结构光系统发射、接收、计算三个核心要素以及互相制约的关系。作为中科融合的3D立体视觉芯片技术介绍的第一部分,为读者提供基本的框架原理,为后续对于TI技术的解读,以及中科融合技术路线创新的基础,提供注解。