今天,分享一篇烽火通信数据中心节能方案及趋势浅谈,希望以下烽火通信数据中心节能方案及趋势浅谈的内容对您有用。

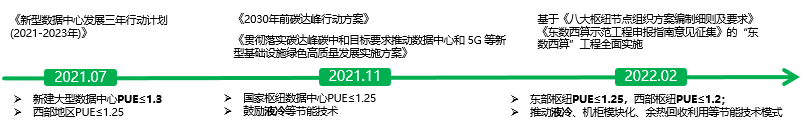

随着碳达峰、碳中和目标的推进,国家在数据中心领域也出台了一系列政策,对数据中心PUE提出了明确的要求,以期实现节能减排的目的。

根据今年最新政策显示,国家层面8大计算枢纽节点中,明确了西部枢纽节点PUE在1.2以下,东部枢纽节点PUE在1.25以下。同时,各省市发改委也发布了各领域的碳达峰实施方案,规定了数据中心PUE的具体要求,对于新建的中大型数据中心,普遍要求1.3以下。随着国标GB40879《数据中心能效限定值及能效等级》的实施,在未来,数据中心的节能性将逐步成为强制要求。地方层面,上海、深圳也密集出台相应的政策,除新建数据中心以外,存量运营的数据中心也需要进行改造升级,以满足最新的节能政策要求。

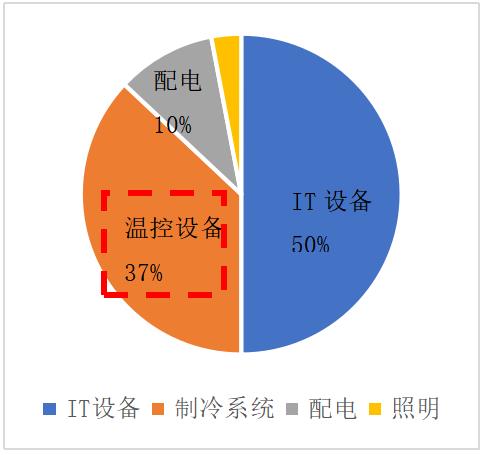

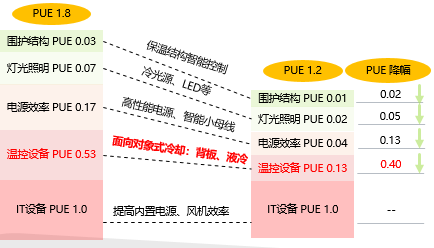

如下图的PUE拆解图所示,可以看到温控设备在整个数据中心PUE中的占比较高。目前电源效率的提升空间已非常有限,那么制冷系统的能效提升,对降低数据中心PUE将起到决定性的作用,采用高效科学的温控设备和热管理技术,可助力数据中心在当前标准下,直接跻身一级能效的水平。

如考虑将PUE的值分解成各个因子,可以看到,如果要将数据中心PUE从1.8降低至1.2,温控设备的优化潜力最高。在PUE≤1.2的严苛标准下,对数据中心能源设备的效率是极大的挑战,数据中心的温控设备,需要不断的升级,来实现未来超低PUE的需求和挑战。

数据中心温控发展

经过近几年的快速发展,数据中心温控设备,呈现出多样化的发展趋势,并且不断创新升级,用以实现自身更高能效运行,以及数据中心整体更低PUE要求。目前的数据中心温控方式,由最早的传统房级风冷空调,逐步演进为微模块+列间空调、冷冻水+末端背板等高效散热的方式。

微模块 + 列间空调

该类温控系统,通过微模块的方式,实现冷热风隔离,有效避免房级空调的混风,保证空调吹出的冷风,全部用于服务器散热,从而避免冷源浪费。同时,列间空调一般采用搭配微模块的方式,可以做到更高回风温度和更高送风温度,可以进一步提升制冷系统的能效水平。

近期,行业中针对机房空调高蒸发温度的特点,推出了超低压比压缩机进行适配。在保证回油可靠性的前提下,低压比压缩机可以支持更宽范围工况。相同制冷量需求的情况下,功耗更低,能效更高。随着该类压缩机的应用,风冷列间空调,满负荷时的高配能效水平,将由4.0向5.0迈进。

一般情况,在北方地区,采用该类温控系统的数据中心,PUE值大概在1.4~1.5之间,在南方地区,PUE值大概在1.5~1.6之间。

风冷列间空调

风冷列间空调2.2冷冻水+末端背板温控系统

该类温控系统的核心在于,使用能效水平较高的水机作为制冷源。通过冷却塔+冷冻水机+空调末端的组合方式,实现高效制冷。水机机组在满负荷运行时,能效可达到7.0左右;在部分负荷运行时,能效可达到更高。相比传统风冷空调,采用冷冻水机组的数据中心温控系统,效率比传统风冷空调高出60%以上。

考虑到数据中心室内温度偏高的特点,适当提高冷冻水的进出水温度,可进一步提升温控系统的能效。

一般情况,在北方地区,水冷系统的PUE值大概在1.2~1.3之间;在南方地区,水冷系统的PUE值大概在1.3~1.4之间。

2.3 烽火通信温控产品简介

针对不同数据中心的PUE需求,以及不同散热方式的需求,烽火可为用户提供多样化的温控解决方案。烽火温控产品,涵盖房级空调、列间空调、末端热管空调、末端冷冻水空调等等。同时具备工程化一体交付的能力,为客户提供全方位温控解决方案。

烽火通信始终致力于温控产品能效和可靠性的稳步升级,结合机房环境高温的特点,尝试探索更低压比运行的空调系统,实现产品能效的持续提升。目前,烽火通信风冷列间空调EER可达4.0及以上。

新型末端空调,属于更高效的面向对象式的温控产品。目前烽火已涵盖末端空调的全部系列,可全面满足客户的不同场景需求。同时,烽火不断致力于产品细节的优化,通过改进换热器、改善风扇叶型、优化流道等方法,实现末端空调产品关键性能的不断提升。目前背板空调系列的能效比,超出主流水平10%以上,处于行业领先水平。

极致PUE探索—液冷温控技术

3.1液冷技术发展

从制冷原理角度来看,传统空调的主动制冷,属于逆卡诺循环。从自身循环角度,这种制冷方式,是将热量从低温向高温搬运,势必会经过大量功率消耗,也就限制了其能效的进一步提升。

相比传统制冷,液冷优势则非常明显。液冷循环属于正卡诺循环,这种散热方式,是将热量从高温向低温正向传输,仅需要提供循环动力即可。所以,采用液冷温控技术,将使得温控系统的能效大幅升高;进而,温控系统在数据中心中的能耗大幅度降低,从而实现数据中心PUE的跨越式提升。

3.2液冷类型

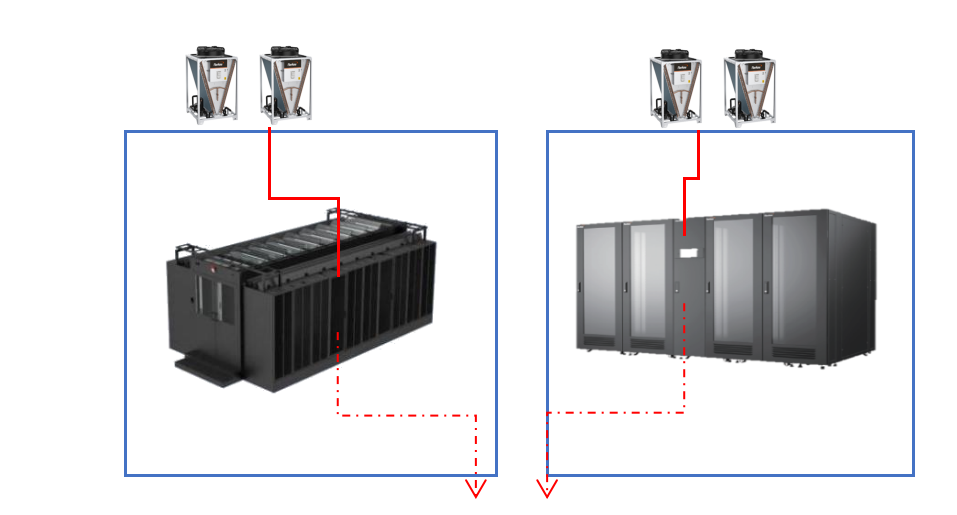

3.2.1冷板式液冷

板式液冷是目前液冷散热中,发展较为成熟、可靠性较高的液冷散热方式。它是一种间接接触式的散热,通过在CPU/GPU表面附着一块冷板,芯片将热量传递给冷板,再由冷板内的液体将热量带走。

该种散热方式的优点,在于冷却液不与IT设备直接接触,可靠性高,且目前支持的最高热流密度,已达到150W/cm2以上,远远超过浸没式液冷。同时,其缺点主要是较难实现100%液冷,目前的IT设备,75~85%的热量可由液冷带走,剩余25~15%的热量,仍需风冷带走。

由于风冷散热效率相对较低,所以采用板式液冷散热系统时,其整体能效会低于浸没式液冷。

鉴于目前板式液冷的热流密度已可以做到很高,未来板式液冷的发展方向,主要是提高IT设备的风液比,通过改进IT硬件架构,实现90%以上的液冷占比。一般在我国广东地区,采用板式液冷的数据中心,全年PUE可达1.15左右。

3.2.2 浸没式液冷

浸没式液冷,也是目前液冷散热领域的一种重要类型。其核心特点在于冷却液直接和IT设备接触。目前主流的冷却液,有油冷、氟化液等。浸没式液冷的主要优点是,IT设备直接浸泡在冷却液中,100%热量全部由液冷带走。同样,其缺点也非常明显,支持的热流密度较低,目前主流水平在100W/cm2以下。同时,氟化液价格昂贵,长期使用时,对一些器件模块的稳定性,仍存在一些影响。所以,目前市场上的主流液冷散热方式,仍以板式液冷居多。一般在我国广东地区,采用浸没式液冷的数据中心,全年PUE可达1.1左右。

3.3液冷经济性分析

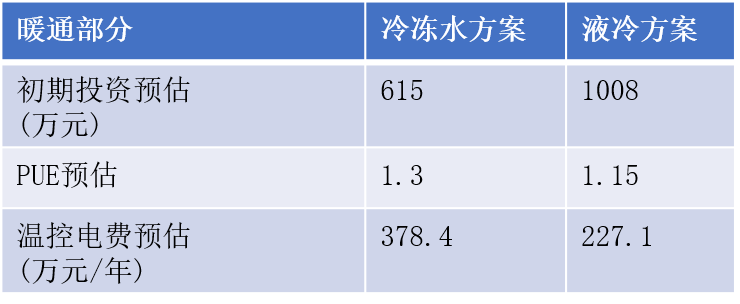

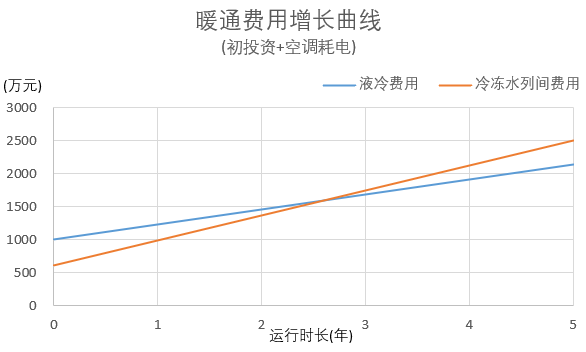

液冷的散热效率,远超传统风冷散热。所以采用液冷系统的数据中心,温控部分的耗电,远低于传统风冷散热。但是由于液冷温控系统相比风冷温控系统更复杂,故初期投入成本高于传统的风冷散热系统。以1400KW小型数据中心为例:

对比冷冻水方案与板式液冷方案发现,暖通部分的初期投资,液冷方案高于冷冻水方案;但全年运行电费,板式液冷方案远低于冷冻水方案。故考虑综合的投入回报,约2.5年即可收回初期的投资差距。

注:电费以1元/kW*h计算

年耗电费用=IT设备总负荷*PUE*24*365*1

同时,随着数据中心规模越大,液冷方案的优势则会更加明显。有数据显示,当单柜功率超过15KW时,板式液冷的单柜TCO优势将超过传统风冷。

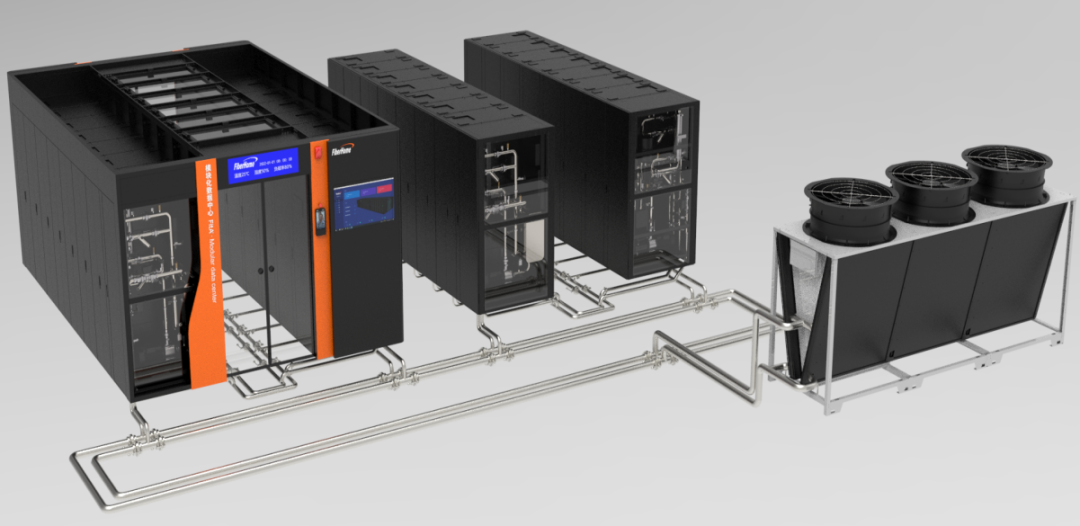

3.4 烽火液冷解决方案

烽火具备成熟的板式液冷温控系统,可为用户提供全面的液冷解决方案。液冷温控产品,涵盖液冷CDU、液冷机柜、环形管网、干冷器等关键设备。提供工程落地服务,以及全面的动环监测系统。

烽火通信液冷产品中,液冷CDU制冷量涵盖100~800KW,设备能效比(换热量/功率)达到100以上;液冷机柜支持功率达到36KW及以上,并支持用户客制化;液冷环形管网全部采用不锈钢材质,工厂预制,并经过精细抛光、酸洗等严苛工艺过程,保证管路超高洁净度。

烽火通信在板式液冷领域,持续致力于超低电导率冷却液的开发应用,实现快速检测漏液,不损害IT设备,为用户提供绝对安全可靠的应用环境。

总结

随着国家双碳目标推进,以及数据中心领域PUE要求的逐步提升,数据中心温控系统的升级势在必行。虽然目前数据中心温控产品呈现贴合区域特征的多样化发展趋势,但在未来,主流PUE要进入1.1~1.2区间变为强制要求时,液冷温控系统,将会成为必然的散热选择。

烽火通信将液冷作为一项重要的节能温控技术,在后续的产品研发中会持续发展升级。烽火从板式液冷入手,逐步发展浸没液冷、冷媒相变液冷、喷射液冷等多样化液冷温控模式。实现不同热流密度、不同应用场景的全范围覆盖。

同时,在数据中心节能要求不断升级的大背景下,烽火通信将基于在温控领域多年的技术积累,锚定节能降碳的长远目标,持续探索应用于数据中心领域的新型温控技术,为未来实现碳达峰、碳中和,贡献一份力量。