今天,分享一篇细数NLP与CV的融合创新盘点多模态深度学习这几年,希望以下细数NLP与CV的融合创新盘点多模态深度学习这几年的内容对您有用。

机器之心报道

编辑:悉闲

本文概述了最先进的多模态深度学习研究中使用的各类方法。

近年来,NLP 和 CV 领域在方法上突破不断。不只是单模态模型有所进展,而大规模多模态方法也已经成为非常热门的研究领域。

论文地址:https://arxiv.org/pdf/2301.04856v1.pdf

项目地址:https://github.com/slds-lmu/seminar_multimodal_dl

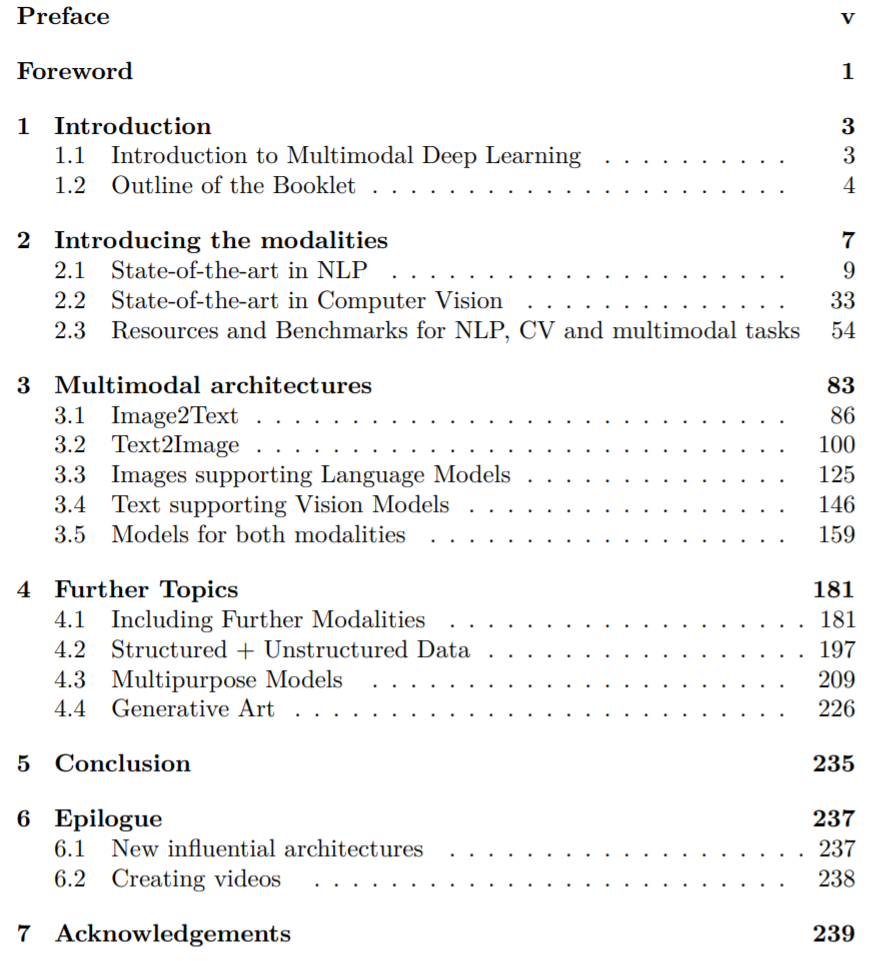

在最近的一篇论文中,研究者Matthias Aßenmacher回顾梳理了深度学习这两个子领域当前最先进的研究方法,并尝试进行全面的概述。此外,还讨论了将一种模态转换为另一种模态的建模框架(第 3.1 章和第 3.2 章),以及利用一种模态增强另一种模态的表征学习模型(第 3.3 章和第 3.4 章)。研究者引入了侧重同时处理两种模态的架构(第 3.5 章)作为第二部分的尾声。最后,论文还涵盖了其他模态(第 4.1 章和第 4.2 章)以及通用多模态模型(第 4.3 章),这些模型能够在一个统一架构中处理不同模态上的不同任务。一个有趣的应用(「生成艺术」,第 4.4 章)最终成为这篇综述的锦上添花之笔。

论文章节目录如下:

多模态深度学习简介

人类有五种基本感官:听觉、触觉、嗅觉、味觉和视觉。借由这五种模式,我们得以感知和理解周围的世界。「多模态」则意味着同时利用多种信息渠道的结合来理解周围环境。例如,当蹒跚学步的孩子学习「猫」这个词时,他们会用不同的方式大声说出这个词,指着猫,发出类似「喵喵」的声音。AI 研究人员以人类学习过程为范式,结合不同模态来训练深度学习模型。

从表面上看,深度学习算法通过训练神经网络以优化损失函数来优化定义的目标函数。优化,即将损失最小化,通过称为梯度下降的数值优化程序完成。因此,深度学习模型只能处理数字输入,也只能产生数字输出。然而,在多模态任务中,我们经常遇到图片或文本等非结构化数据。所以,关于多模态任务的首要问题是如何用数字表征输入;其次则是如何恰当地组合不同模态。

例如,训练深度学习模型来生成一张猫的图片可能就是一个典型的任务。首先,计算机需要理解文本输入「猫」,然后以某种方式将这些信息转换成特定图像。因此,确定输入文本中单词间的上下文关系和输出图像中像素点间的空间关系很有必要。对幼儿来说可能很容易这件事,对于计算机却可能是巨大挑战。二者都必须对「猫」这个词有一定理解,包括这个动物的内涵和外观。

当前深度学习领域一种常见方法是生成嵌入,用数字形式将猫表征为某个潜在空间中的向量。为了实现这一点,近年来已经开发出各种方法和算法架构。本文概述了最先进(SOTA)多模态深度学习中使用的各类方法,以克服非结构化数据和不同模态输入组合带来的挑战。

章节介绍

因为多模态模型通常以文本和图像作为输入或输出,所以第2章着重介绍了自然语言处理(NLP)和计算机视觉(CV)方法。NLP 领域的方法主要在于文本数据处理,而 CV 多进行图像处理。

关于 NLP(第 2.1 小节)的一个非常重要的概念叫做词嵌入,几乎是现在所有多模态深度学习架构的重要组成部分。这一概念也为基于Transformer的模型奠定了基础,比如 BERT ,该模型在几个 NLP 任务中都取得了重大进展。特别是Transformer的自注意力机制彻底改变了 NLP 模型,这也是为什么大多数 NLP 模型将Transformer作为核心。

在计算机视觉(第 2.2 小节)中,作者介绍里不同的网络架构,即 ResNet、EfficientNet、SimCLR和BYOL。在这两个领域,比较不同方法及其在富有挑战性的基准上表现如何是非常有意义的。因此,第 2 章末 2.3 小节对 CV 和 NLP 的不同数据集、预训练任务和基准进行了全面概括。

第3章侧重于不同的多模态架构,涵盖文本和图像的多种组合方式,提出的模型相组合并推进了 NLP 和 CV 不同方法的研究。首先介绍了 Img2Text 任务(第 3.1 小节)、用于目标识别的 Microsoft COCO 数据集和用于图像捕获的Meshed-Memory Transformer。

另外,研究人员开发了基于短文本 prompt 生成图片的方法(第 3.2 小节)。完成这项任务的第一个模型是生成对抗网络(GAN)和变分自编码器(VAE)。近年来,这些方法不断改进,今天的 SOTA Transformer架构和文本引导的扩散模型如 DALL-E和 GLIDE都取得了显著成果。另一个有趣的问题是,如何利用图像来支持语言模型(第 3.3 小节)。可通过顺序嵌入、更高级的实际嵌入或直接在Transformer内部实现。

也可以看一下支持文本的 CV 模型,如 CLIP、ALIGN和 Florence(第 3.4 小节)。基础模型的使用意味着模型重用(例如 DALL-E 2 中的 CLIP),以及文本与图像连接的对比损失。此外,zero-shot 使得通过微调就可毫不费力对新的和不可见的数据进行分类。特别是用于图像分类和生成的开源架构 CLIP去年颇受关注。第3章末介绍了同时处理文本和图像的一些其他架构(第 3.5 小节)。

例如,Data2Sec 用相同的学习方法处理语音、视觉和语言,并尝试以此找到一种通用方法,能在一个架构中处理不同模态。此外,VilBert扩展了流行的 BERT 架构,通过实现共同注意力来处理图像和文本输入。这种方法也用于谷歌的 Deepmind Flamingo。此外,Flamingo 的目标是通过少样本学习和冻结预训练的视觉和语言模型,用单个视觉语言模型处理多个任务。

最后一章(第 4 章)介绍了能够处理文本和图像以外模态的方法,例如视频、语音或表格数据。总体目标是探索通用的多模态架构,并非为模态而模态,而是为从容应对挑战。因此还需处理多模态融合和对齐的问题,决定要使用联合表征还是协调表征(第 4.1 小节)。此外,还将更详细地介绍如何精准组合结构化数据和非结构化数据(第 4.2 小节)。

作者还提出了近年来形成的不同融合策略,本文通过生存分析和经济学中的两个用例加以说明。除此之外,另一个有趣的研究问题是,如何在一个所谓的多用途模型(第 4.3 小节)中处理不同任务,就像谷歌研究人员在其「Pathway」模型中创建的那样。最后,文章会展示多模态深度学习在艺术场景中的一个典型应用,使用 DALL-E等图像生成模型来创建生成艺术领域的艺术作品(第 4.4 小节)。

了解更多内容,请参考原论文。