原标题:逼真实时“数字人”是如何生产出来的?

文:靠谱的阿星

数字技术是信息时代的引擎,当前AR、VR以及3D技术重新引发人们关注,必将在可视化、高精度化为信息世界带来重塑。

比如我们近年来看到的一些新的国漫电影已经不能视为卡通片,其人物、场景的光影渲染和逼真效果足以比真人出镜的电影更为震撼,叫好又叫座;其幕后的数字技术开发团队依靠剧本和故事脉络制作DEMO从而寻找到意向投资人,不仅减少了资方的风险,也让观众能看到更多新锐、新颖的作品。

实际上除电影以外,还有一些虚拟形象IP、广告片、楼宇桥梁建筑设计、工厂规划图、室内装饰全景、汽车(全景)预定等等都需要用到3D以及AR视觉化设计的数字技术,以呈现出预期逼真的蓝图效果或制造出用户线上互动的交互界面。

很多人不知道的是,这种数字技术和工具最早是在游戏开发中应用成熟之后,逐渐“外溢”到其他行业和应用场景的,并且底层开发工作和操作系统就是虚幻引擎(Unreal Engine,以下简称“UE”),这家公司可以说是网络游戏和视觉设计领域的安卓或者苹果,外界一直难窥其貌。

我们更近一步追问,UE是否可以在数字世界之中用类似的技术手段来模拟人而非是卡通式的动画,类似于《三体》VR游戏之中用历史名人来亲历三体环境一样。答案是肯定的,相关技术条件以及工具完全具备,因为在大量游戏和电影场景之中人物的逼真度都要求相应的开发工具必须使得人物的面孔、眼睛、皮肤、头发以及走动光影变化等足够的细腻逼真。

所谓“逼真、实时数字人”并非是虚拟创作的IP或者二次元形象,实际上是真人,逼真、实时的“数字人”,阿星理解是真实的人三维化,类似于是数字化的“杜莎夫人馆”,并且是能够适应于普通人的,因此其技术突破和迭代可能对于AR、VR等普及化、大众化意义重大。

(杜莎夫人馆中陈列的真人明星蜡像)

逼真、实时数字人究竟是如何生产出来的,又将应用在哪些场景之中,当前的发展瓶颈在哪里?笔者有幸请教中国人民大学产业研究院助理院长、文化科技融合中心主任宋震,以及北京理工大学光电学院光电信息技术与颜色工程研究所研究员翁冬冬,他们是高校相关专业研究的权威,在“数字人”呈现和探索处于前沿。

一、用游戏开发全套工具和系统来做“逼真、实时数字人”

先来介绍下,虚幻引擎是游戏公司 Epic Games所开发的操作系统,能够为游戏开发者提供大量游戏开发之中所需要的核心技术、数据生成工具以及基础支持,也就是说,UE使得游戏开发者不需要从0开始写代码做每一帧的画面或者设计相应场景,让游戏开发者更加聚焦于故事和难度设置上,回归到游戏本身,让开发变得更加轻松。

在数字世界之中,这就需要UE本身不断迭代技术和工具包,以满足线上数字世界游戏化、交互化以及游戏世界逼真化、动态化的需求,用越来越特效、逼真的图像处理来对画面进行更为真实、更为细致的全面刻画。

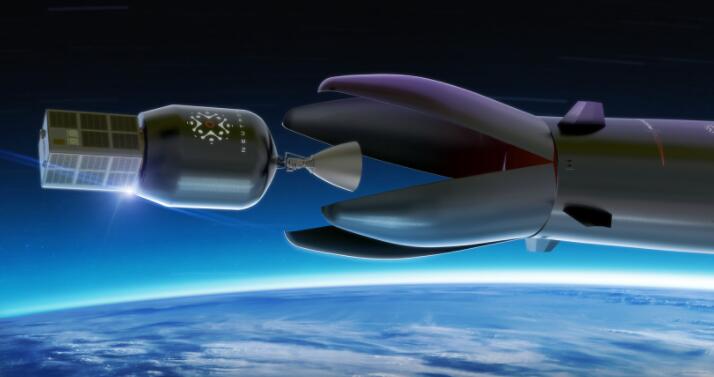

截止2021年虚幻引擎已经更新到UE5,主要基于Nanite(虚拟微多边形几何体)和Lumen(动态全局光照)的核心技术以及支持上亿、几十亿甚至无上限的三角面的渲染,不仅为游戏开发和设计师创意提供了广阔的舞台,还能够广泛应用在人、物、故事以及各种内容之中。

在游戏世界之中,最难表现的依然是人,因为如果是真实、逼真的人的话,他的面孔或表情是随着年龄、心情、状态而发生变化的,在不同场景之中,人们的眼神、光线以及脚步、身形等都是很难用虚拟想象进行刻画。正如现实生活刻画精彩有时胜过于小说,而真实记录数字人工作量实际上也远远高于虚拟创作人物。比如12月份网易云在港上市就有两个数字人“丁磊”在线上敲钟,有网友认为是丁磊的美颜版,实际上这与真正的“数字人”还有差距,尤其是在面部表情上,观众还是能够一眼看出来“不够逼真”。

人们判断一个数字人逼真不逼真、鲜活不鲜活最重要的关注点是在表情上。宋震说:“人对于表情差异是非常敏感的,人的脸上有70多块肌肉,能够产生很多复杂和微妙的变化,面孔以及表情数字化是数字人的重点和难点。”

制造逼真实时数字人,首先需要对模特或者原型人物进行“照相”采集工作,主要是基于测量摄影的孪生数字人方案,通过球形梯队照明采集模特在不同光影明暗之下的微表情变化,通过对素材(照片为RAW文件)进行校色、抠像并对面部数据处理和渲染等处理之后进行绑定在系统之中,据了解,一个逼真实时数字人可能有200个G原始素材。

据宋震老师介绍,逼真实时数字人创造流程主要分为“光影采集”、“数据清理”、“重拓扑”、“贴图处理”、“绑定”、“毛发制定”、“导入UE”、“光照和氛围”、“动态测试"等九个步骤,这些步骤组合起来都需要UE的深度参与。

要让专业制造高精度实时数字人能够保持表情实时变化以及相应的抠像处理、光影变化、声音匹配等都需要用到Metahuman工具。宋震老师说:“虚幻引擎在2021年上半年推出了Metahuman工具,很快就在3D数字人领域树立了行业标杆和标准。”

由于Metahuman不只有强大的创意工具比如数字人材质系统、动画系统等降低项目复杂度,还能够借助于光学扫描设备,Metahuman的技术管线能够极大的提高生产效率和表现效果,目前的数字人生产管线也能够迁移到Metahuman上,实现了很好的兼容。

在数字人创建过程中,不只是用到一两个DCC(数字内容生成)工具,包含着很多复杂完整的生态之中。翁冬冬老师说“虚幻(引擎)不只是实时可视化的工具,还是整个逼真实时数字人的平台,甚至称之为操作系统也不过。因为所有数字人(资产)生成、开启使用都得使用UE,虚幻引擎实际上是把各种各样的工具汇聚在一起,而这是操作系统最有价值的。”

虚幻引擎在制作3D数字内容生产之中提供的便利就好比一个厨师要为客户制造美味可口的菜肴,不需要亲自去购买各种厨具或者去菜场买菜,很多案台、锅碗、调料都已经准备妥当,更加便于厨师发挥自己的厨艺。

二、高精度逼真实时数字人已能够生产,突破口是历史名人数字化

逼真数字人作为3D呈现的“照片”和“影像”,随着各种数字人生成技术的成熟,会逐渐成为现实并应用到VR(虚拟现实)和AR(增强现实)的设备之中呈现。

宋震老师在演讲之中强调,虚幻引擎的Metahuman与RTX(光线追踪技术)相结合渲染质量会更加好,未来与AI技术深度结合,未来高精度的虚幻人将会很快出现,并且虚拟人的定制会在直播、演唱会等表演场景之中率先应用。

除现实场景数字人出现以外,这样的技术实际上还是能够帮助人们去恢复一些著名历史人物,让历史IP走进人们的现实世界之中,比如我们曾经在历史上看到的一些著名历史人物的画像,很多是后代画家找神态类似的人临摹的,实际上逼真数字人技术有望和很多博物馆以及相关机构深度合作的。

翁冬冬老师说:“团队希望能做出一套中华名人的标准数字资产,尤其从近代有照片的名人入手来推动”。他在虚幻引擎技术开放日上介绍了团队对梅兰芳先生的数字人生产的样本案例。

翁冬冬老师说,“北京理工大学联合中央戏剧学院负责通过高保真实时数字技术对梅兰芳先生进行复现,这将成为国内第一套真正意义上的京剧数字人项目。”

据了解,翁老师团队对梅先生的影像资料、照片以及舞台场景进行大量的研究和还原工作,从工艺、动作、服饰、文玩进行研究,通雕刻构建高精度实体模型,再采用UE数字雕刻方式对扫描数据进行反复精修,基于引导线的构建方式对发型等进行高保真发束,以真实立体裁衣为基础构建高保真服饰等等,最终制作出梅兰芳先生的3D数字人。

数字人将结合VR和AR,以三维的形式呈现在观众面前,假设用户想看梅兰芳先生的表演不是在电视屏幕或者是投影薄膜上进行观赏,而是面对面和“真人”进行交流。

翁冬冬老师说:“凡是需要有真人或者真实的场景出现,都可以应用数字孪生技术进行还原。站在商业化角度看来,实际上数字人本身也是一种生产工具,能以高逼真数字人为数字资产或者IP来创造影视剧或者拍视频。而在有人的地方,用人来生产内容的地方,数字人都可以派上用场。”

当前在国内,数字人产业链和研发,在北京、上海、深圳等大城市已经落地和推进。翁冬冬老师给出预测,“真实逼真数字人会成为未来三年后的发展方向。”

当然,对于实时、逼真数字人本身相应的知识产权和法律完善也是两位老师研究课题,毕竟技术发展往往需要相应的监管随时跟上脚步。

结语

从人类历史就是一部分人的再呈现角度来看,逼真实时数字人实现了人从二维化电子屏式呈现到三维式的实时呈现,这的确是一项了不起的技术发展;其生产借助于虚幻引擎(UE)开发工具以及操作系统予以完成,未来还将逐渐轻便化、简捷化,在专业门槛上降低准入门槛,让更多人实时远程精准呈现不再是难事,无论是影视创作还是商业化都有巨大的想象空间,有关数字人相应的资产生成、保护、流转、使用逐渐也会引人关注。面对这一技术创新,将会带来商业世界的深远影响,现在依然处在积极探索早期阶段。

特别声明:本文为合作媒体授权DoNews专栏转载,文章版权归原作者及原出处所有。文章系作者个人观点,不代表DoNews专栏的立场,转载请联系原作者及原出处获取授权。