图片来源:Mati Mango from Pexels

图片来源:Mati Mango from Pexels1964 年,数学家、计算机科学家 Woodrow Bledsoe 首次尝试将嫌疑犯的面部与计算机中存储的面部照片相匹配的任务:他测量出打印出的照片中不同面部特征之间的距离,并将其输入计算机程序。这个步骤的完成,开启了接下里数十年里人类教会机器识别人脸的尝试。

43 年来 100 多个数据集、1.45 亿图像的调查

无论是在学校、便利店、公共广场、音乐会、公寓大楼、机场、社区公园,还是在个人设备上,面部处理技术(FPT, Facial Processing Technology)正不断地以无数种难以解释的方式,潜移默化地渗透到我们的日常生活中。

在早些时候,美国国家标准协会(NIST, the National Institute of Standards)曾自豪地宣布,从 2014 年到 2018 年,FPT 的性能提高了 20 倍,失败率仅为 0.2%。

然而,现实世界中所呈现出的一系列失败的案例,残酷地打破了面部识别(face identification)作为学术界神话的传言。

2016 年至 2018 年期间,在伦敦进行的 8 次 FPT 部署的试验中导致了对犯罪嫌疑人的错误识别率高达 96%;而 2019 年的一份报告中发现,在伦敦警察厅(London’s Metropolitan)所使用的面部识别工具所标记的嫌疑人中,错误识别率达到了 81%。

类似的,纽约市大都会运输局(MTA, Metropolitan Transportation Authority)在面部识别的错误率达到 100% 后,果断停止试点项目。

且这些失败在人口统计学的子群体中并非平均分布。以肤色为例,面部识别在识别肤色偏深的黑人或棕色人种时的准确率较低。据 2018 年的一项研究显示,相比于肤色较浅的男性群组,商业面部识别 API 在肤色较深的女性群组上的表现要低 30%。

美国国家标准与技术研究院(NIST, National Institute of Standards and Technology)和其他学者的研究,已经充分证实了这些表现差异。同样,在坐实亚马逊的 Rekognition 图像识别系统错误地匹配了 28 名国会议员的一年后,该技术又错误地将 27 名运动员与犯罪嫌疑人的脸部照片相匹配,由此便引起了公众对该技术在部署中存在局限性的特别关注。

技术局限性以外,更加棘手的是隐私问题。

在美国,许多州都通过了专门针对 FPT 系统开发和运行中固有的侵犯隐私问题的法律,更多的州还提出了立法提案。联邦方面,2019 年的《商业面部识别隐私法》(the Commercial Facial Recognition Privacy Act of 2019)中明令禁止 “在未获得终端用户的肯定性同意的情况下,某些实体使用面部识别技术来识别或跟踪终端用户”。

尽管公众越来越深刻地意识到,这些系统一旦用之于众,将会引发一系列的现实难题,但学术研究仍在持续给出 “面部识别系统在基准数据集上性能近乎完美” 的报告。

为了更好地理解在当前有限的评估规范下,这些系统的感知功能与现实部署时整体的性能表现之间的不协调,AAAI 2021 文章 About Face: A Survey of Facial Recognition Evaluation 中,来自 Mozilla 的 Inioluwa Deborah Raji 和纽约大学 AI Now Institute 的 Genevieve Fried,调查了自 1976 年至今的数字面部处理技术(digital facial processing technology)和数据集发展。

他们追踪了 1976 年~2019 年年间、100 多个用于训练面部识别系统的数据集情况,涵盖来自 1700 万个调查对象的 1.45 亿张图像。

这也是目前所知的此类调查中规模最大、最新的一次。

面部识别发展的 4 个历史阶段

这些数据集的形成本身就是一个动态的过程,由政治动机、技术能力和当前规范的变化共同驱动。

团队通过分析评估任务、训练数据和度量标准的演变,更清晰地了解评估的内容,从而在部署环境中真正捕获这些系统的可靠表示,以便在现实世界中建立起对这项技术功能更客观、更深入的理解。

首先来看下,这项研究中提到的面部处理技术究竟是指什么。

在此,面部处理技术 FPT 将被视为一个广义的术语,涵盖任何涉及人脸图像的识别和表征的任务,包括人脸检测(face detection)—— 在图像的边界框中定位人脸的任务;人脸验证(face verification)—— 对查询图像和给定图像进行一对一的确认;面部识别(face identification)—— 对查询图像和给定图像库进行一对多的最相似结果匹配;以及面部分析(facial analysis)—— 一种用于确定面部特征的分类任务,诸如年龄、性别或姿势等身体或人口统计学特征,以及更多的情景特征,如面部表情。

目前,主流的商业面部识别产品仍然主要基于 2D 静态图像的预测。

因此研究将调查范围限制在现在线可用的 2D 静态图像摄影面部识别基准,即不讨论由红外或其他传感器输出图、草图或绘图数据集、基于视频的数据集、3-D 图像数据集以及诸如体态识别这样的非视觉人脸图像集。

在本研究中,团队将审核(audit)或评估(evaluation)看作是一系列用于确定特定技术适用性的过程,以实现其在指定部署中的预期使用。显然,该方法独立于此定义,因此评价方法会包含定量和定性两个方面。

而在时间范畴上,由面部识别发展的三个关键性转折点所划分,研究将 FBT 发展主要分为四个时期。

三个关键性转折点分别是:

(1)于 1996 年创建面部识别技术(FERET)数据库,它是首个用于学术和商业研究的大规模人脸数据集;

(2)于 2007 年创建 LFW (Labeled Faces in the Wild)数据集,它是首个源于 Web 的人脸数据集,主要用于研究非受限情况下的面部识别问题;

(3)于 2014 年开发 DeepFace 数据集,它是第一个在人脸验证任务上击败人类表现的面部识别模型,并使用目前主流的深度学习技术进行训练。

面部识别发展的四个阶段及其具体任务依次是:

第一阶段:早期研究阶段(1964-1995)

面部识别算不上很新鲜的概念,这个任务借由计算机来实现可以追溯到 20 世纪 60 年代。

1964 年,Woodrow Bledsoe 首次尝试以计算形式进行面部识别任务。在某情报机构的资助下,他通过计算机编程将嫌疑人的身份和面部照片书中的身份联系起来。Bledsoe 最初的方法是用计算出的面部特征之间的距离矢量并对每个人进行编码,这种方法虽然很流行,但是计算成本大、效率低。这在当时的技术条件下,Bledsoe 每小时只能处理大约 40 张图片。

后来,一种名为特征脸(eigenfaces)的新方法,可以实现在低维空间中表示人脸特征的像素强度,成为了一种有吸引力的替代方法。然而,在当时通过获取足量数据来尝试这种新方法,仍十分具有挑战性,因为研究人员将不得不招募、雇佣模特和摄影师,保证拍摄场景设置上的一致性,并手动标记诸如面部关键特征(facial landmarks)的数据。

第二阶段:“新生物识别” 的商业可行性阶段(1996-2006)

到 1996 年,政府官员已经承认并接受了这样一个事实:人脸是一种非侵入性的生物特征,可以用于跟踪和识别个人,而不需要他们的主动参与。因此,美国国防部和 NIST 提供了 650 万美元的资金,创建了 FERET 数据集,为研究人员提供在该领域取得进展所需的数据。

在 1993 年 8 月至 1996 年 7 月期间,基准测试从 856 个人的 2413 张静态人脸图像增长到包含 1199 个人的 14,126 张人脸图像。到了 2000 年,鉴于 FERET 数据库成功激发了面部识别领域的研究兴趣,特别是该技术开始迈出商业化步伐,并推动了 NIST 发布面部识别算法测试(FVRT, the Facial Recognition Vendor Test),这项基准旨在评估新兴的商业系统。

随后,更大、更丰富的数据集层出不穷,诸如支持向量机(SVM, Support Vector Machines)、卷积神经网络(CNNs, Convolutional Neural Networks)和隐马尔可夫模型(HMMs, Hidden Markov Models)之类的方法,让面部识别任务取得了一些令人鼓舞的成果。但是,早期方法在实际的应用中也存在某些弊端,无法在各种环境中很好兼容,而且算法的准确率和算力仍需要提升。

第三阶段:不受限制的主流开发阶段(2007-2013)

LFW 数据集的开发满足了研究人员获取更自然定位和更多样化数据的愿望。该数据集包含 1680 个人的超过 13000 张图片,其中涵盖了姿势(poses)、照明条件(illumination conditions)和表情(expressions)的无限组合。

由此,LFW 激发了一波用于面部识别模型训练和基准测试的网络人脸数据集的热潮 —— 包括许多未经在线平台同意而获取图像的数据集,比如谷歌图像搜索(Google Image search)、雅虎资讯(Yahoo News)。

随着人们对非结构化、不受约束的 “野生” 数据需求的增长,像 ChokePoint 和 SCface 这样的基准数据也大量涌现,不仅数据集越来越拟合真实世界的情况,FVRT 也得到了广泛的发展,从 2000 年最初实施的 1462 人的 13872 张图像增长到 2013 年 1440 万人的 3020 万张静态照片。但是,在不受限制的条件下进行面部识别的研究,仍是一项技术挑战。

第四阶段:深度学习的突破阶段(2014 至今)

2012 年 Alexnet 的突破,以及随后在 2014 年引入 DeepFace 模型推动神经网络成为了面部识别发展的主流方法。

由 Facebook 公司开发的 DeepFace,是第一个通过深度学习训练的面部识别模型,也是面部识别模型在任务上逼近人类性能的第一个实例。据称,这是 “迄今为止最大的面部数据集,一个包含超过 4000 个身份的 400 万张面部图像的数据集”。

深度学习技术对面部识别的影响是巨大的;DeepFace 模型在 LFW 测试集上取得了 97.35% 的准确率,相较于之前的前沿技术方法,在误差率上降低了 27%。为了响应这一技术的进步,随后构建的人脸数据集的规模显著增长,目的是适应训练深度学习模型日益增长的数据需求。

这一快速进展也引发了巨大的商业利益。

最早的面部识别算法主要面向安全应用,但在商业化上,面部识别产产品已经涵盖索引和搜索数字图像存储库、定制广告精确投放、用户参与监控、客户人口统计分析等。特别是 2014 年 DeepFace 模型在面部识别方面取得突破之后,该技术率先引领了商业化浪潮。

这一切都建立在广泛发展的面部识别数据集的基础之上。

面部识别数据集 “之最”

研究人员调查的 1976 年至 2019 年间创建的 133 个数据集,总共有了 145,143,610 张图像,包含 17,733,157 张面孔。

其中,最大的数据集是 2018 年 Cele500k 数据集,包含 50,000,000 张图像;来自 NIST 的 FRVT 覆盖了最多的人群,包括 14,400,000 张面孔;而最小的数据集是 1988 年 JACFEE(日本人和白种人面部情绪图像)数据集,包含 4 个人的 56 张图像。

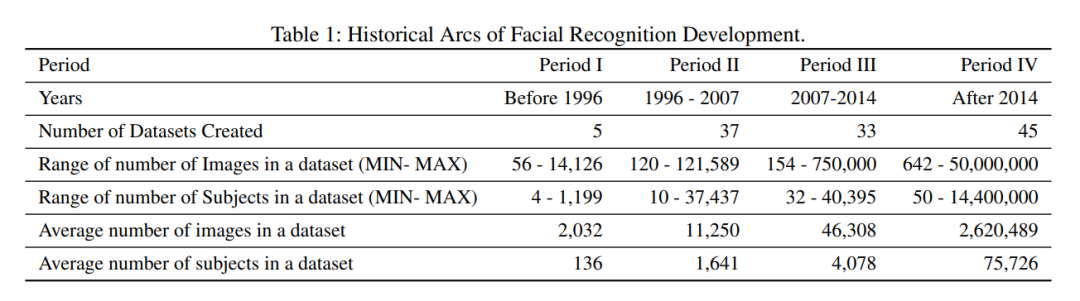

表1

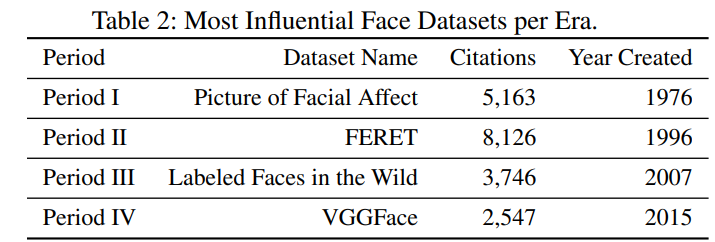

表2

表2然后,团队对这些当前可访问的面部数据集进行了时间顺序分析。表 1 给出了面部识别发展的每个阶段的定量总结,而表 2 展示了每个时代最具影响力的面部数据集。

究竟哪些资助者赞助了这些数据集的开发,同样意义重大。尤其是对于政府数据集而言,所开发技术往往目标明确。例如,NIST FRVT 数据集是由美国国土安全部(the Department of Homeland Security)资助的,包含的数据来自 “美国国务院墨西哥非移民签证档案 "。因此,该技术的优先级和主要应用背景仍然是在执法和安全背景下的安全性、访问控制、可疑识别和视频监控。

从历史上可以看出,政府从一开始就在推动和支持面部识别,目的是实现刑事侦查和监视。

之后,出现了更多样化的应用程序,如将其集成到移动设备、机器人和智能家庭设施用户界面,以监测用户参与或社会目标。

随着时间的推移,面部识别模型又出现了新的分化:不再作为完整的软件包进行发布,取而代之的是作为应用程序接口(APIs, Application Program Interfaces)进行部署,提供预先训练的模型即服务(model-as-a-service),以便集成到任何开发人员应用程序中。

这意味着,任何试图将模型应用到特定场合的开发人员,现在都可以访问面部识别模型。面部识别模型被广泛地部署并嵌入到未知和不可预测的环境中所使用,已然成为常态。

面部分析很可能是模型开发目标最模糊的一类任务,通常涉及 “不可信的面相和颅相学伪科学”(discredited pseudosciences of physiognomy and phrenology),即通过评估对象的外部特征来错误地推断对象的内心状态。这些伪科学任务在系统评估中很少受到质疑,包括预测 “性取向”(sexual orientation)、“吸引力”(attractiveness)、“可雇佣性”(hireability)、“犯罪性”(criminality),甚至是更多被接受但存在争议的属性,如情感、性别和种族等。且在系统测试期间,某些任务或用例可能造成伤害的可能性通常不会被明确地考虑或反映出来。

自 2005 年数据标注众筹平台 Amazon Mechanical Turk(MTurk)推出以来,研究人员开始大量使用该服务,试图清理和理解其数据,同时使用这些数据集完成其他的任务。

然而,图片的某些数据和元标签是有争议的。例如,CelebA 数据集上标签包含一些有问题的、潜在的侮辱性标签,如 “胖”、“双下巴”,或一些不恰当的种族特征,如描述亚洲人的 “尖鼻子”、“窄眼睛”,以及针对于黑人受试者的 “大鼻子” 和 “厚嘴唇”。此外,还涉及一些奇怪的说法和客观上无法统一定义的标签。

在这背后,人脸数据基准实践,是根据在驱动模型开发方面最有影响力的利益相关者的需求所塑造的。

尽管面部数据是生物特征信息,就像指纹一样独特且可识别,它也可以以多种形式随意获取,因此某些被动地收集方式,可能导致严重的隐私侵犯问题。

DeepFace 在 2014 年发布后,深度学习有效性促使人们越来越相信,需要更大规模的数据集来满足此类方法的数据需求。由此,数据集从数以万计的图像,发展到像 MegaMace 和 VGG-Face2 这样以百万计的图像。

当模型开发的数据需求较低时,获取数据源的通常做法是使用摄影数据源 —— 设置照片拍摄,以捕捉控制姿态、光照和表情的面部数据。

用这种方式产生高质量的数据集是非常昂贵的。而且需要注意的是,对于这样的设置,相机设备规格之类的细节,将对图像以及整个数据集的质量至关重要。

当然,也存在替代方案,有时数据集也可能是其他图像数据集的集合,这些数据集可能出于不同的目的而构建,或者只是从自愿的参与者那众包而来,这些参与者在被说服或获得报酬后捐赠了自己的面部数据。

后来,学术界和业界倾向于通过网络搜索 “不受约束” 面孔的静态图像,或者从在线视频中获取帧来得到更多信息。

也就是说,在深度学习的爆炸性数据需求的驱动下,研究人员逐渐放弃了征求人们同意的要求。越来越多人的个人照片在他们不知情的情况下被整合到监视系统中。

论文作者之一 Raji 称,在早期,人们记录和验证面部数据时非常谨慎。

“现在我们不在乎了。她说:“所有这些都被抛弃了。从前只是无法追踪一百万张脸,但在某一历史时间点之后,你甚至无法假装自己拥有控制权。”

失控的不止个人隐私

不再审慎地收集面部数据,也导致了更混乱的数据集的出现:它们可能会无意间包含未成年人的照片,使用种族主义和性别歧视的标签,或者质量和光线不一致。这也是为什么面部识别系统失败应用案例数量持续增加的原因(推荐阅读:他或许是第一位因 AI 错判被捕的无辜者)。

与之相关的更宏观的一个问题是数据集报告的标准化程度欠缺。

许多数据集缺少关于图像收集的来源和方法的信息,或者未能包括宏观(如人口统计)和微观(如图像特定属性或元数据创建)级别的信息,从而产生了不完整的数据集特征图像。

除此之外,数据集可能在学术论文或项目网站上进行描述,然而格式未达成统一,甚至在不同的传播媒介和参考文献之间也存在着不一致。简单举例来说,在一些情况下,网站上报道的图像数量可能与发表的论文中的图像数量不同。

不过,有趣的是,NIST 做了一些全面的报告,这也作为正在进行的 FRVT 挑战系列的一部分。评估报告详细记录了基准数据的构造,包含来源和收集方法等。

他们在 2000 年的评估报告中承认了这样做的重要性:“图像收集和存档是任何评估过程中最重要的两个方面。但不幸的是,它们通常在评价的计划阶段没有得到足够的重视,并且在评价报告中也鲜有提及。”

为了确保可靠性,无论是在道德期望和标准方面,还是在数据本身方面,必须保证所使用基准具有一致性。随着面部识别任务从验证和识别发展到面部分析,潜在的技术问题也从图像相似性搜索任务发展到分类任务。当考虑到人口统计类别的性别限制时,将测试示例划分为不同类别会变得极其具有复杂性和挑战性。

数据集评估是一个至关重要的任务,在此关键点上,应该为面部识别系统提供透明度,甚至问责制,并审视给定数据集的道德规范,以推动更负责的机器学习的发展。面部识别技术带来了复杂的道德和技术挑战,这些挑战将愈发难以回避。

正如论文作者之一 Raji 所表示的,希望这篇论文能够激发研究人员思考如何更好地平衡深度学习带来的性能提升与对道德共识的破坏。

“为了进行深度学习而放弃所有这些道德上的实践,真的值得吗?”