来源:机器之心

这是一场非常好玩,回报丰厚的比赛!四大亮点

阿里、清华、UIUC联手打造CVPR2021挑战者计划第六期。

两个赛道,全球唯一;全球首个提供在线运行环境的白盒对抗攻击竞赛+全球首个在线测试的无限制对抗样本竞赛。

获奖选手将获邀参加CVPR2021线下会议并在workshop上分享。

奖励丰厚!10万美金现金+10万奖品+阿里清华UIUC荣誉证书+顶会颁奖等超预期回报!

CVPR2021官网:

https://aisecure-workshop.github.io/amlcvpr2021/#competition

什么是安全AI挑战者计划?

深度学习作为推动此次人工智能技术发展的核心力量之一,在人脸识别、目标检测、自动驾驶等任务上具有广泛的应用。但是其存在的安全风险往往被人忽视,随着其大规模部署带来日益严重的安全隐患,如何尽早发现模型的安全性漏洞,提升深度学习模型安全性,是当前人工智能领域研究的热点和难点。

针对人工智能安全风险,阿里安全和清华大学,以人工智能的对抗安全为核心,提供场景、技术、数据等支持,召集“挑战者”以攻击者或防守者的身份共同打磨AI模型安全;为广大安全爱好者提供数字基建安全的试炼场,在高难度的真实环境中提升技术。

安全AI挑战者计划迄今已经举办了五期比赛,吸引全球300+校企的上万人参加,通过高难度、高创新、高趣味、高回报的题目任务和运营玩法,使得选手能够实现超预期的累加技术成就。

近期,安全AI挑战者计划第六期进行了进一步升级,阿里安全、清华大学和UIUC在人工智能领域的顶级国际会议CVPR2021上,打造AI安全国际赛事。竞赛由阿里云天池平台提供云上竞赛环境,并链接研究者深度参与。

该比赛针对当前人工智能安全研究的热点问题,围绕不同防御模型对抗攻击和无限制对抗攻击两个具有挑战性的前沿问题,邀请国际顶尖大学和研究机构的相关研究者参赛,力争探索新型的人工智能算法,推动人工智能理论、技术和应用的发展。

赛道一:防御模型白盒对抗攻击

深度学习模型的对抗安全是“道高一尺,魔高一丈”的攻与防的博弈过程。随着对抗攻击威胁的出现,相关研究者从数据、模型和训练方法等方面提出了大量不同的防御方法,以降低深度学习模型应用的安全风险。但是,由于深度学习模型自身的复杂性,目前对于模型的脆弱性机理尚不清晰,导致很多防御算法很快会被新的攻击算法所攻破。

为了更好的评估不同的攻击和防御技术,进而启发新的攻防算法,本次比赛上围绕不同对抗防御策略的有效性进行研究,通过对模型的压力测试发现模型的安全性漏洞,以期更加深入理解深度学习模型工作机理,为人工智能模型在实际应用中安全部署提供理论和技术保障。

同之前的对抗攻防竞赛相比,本次比赛着眼于白盒攻击这一更加基础的研究问题,同时是目前首个提供了在线测试环境的竞赛,以期对不同防御机制的模型进行综合比较分析,对于未来深度学习的安全性研究具有重要的意义。

本次比赛包含三个阶段,其中首阶段是公榜评测,模型对选手公开;第二和第三阶段比测中,防御模型将不对选手公开。选手将通过提交代码的方式,对白盒模型进行攻击并测试其攻击性能。

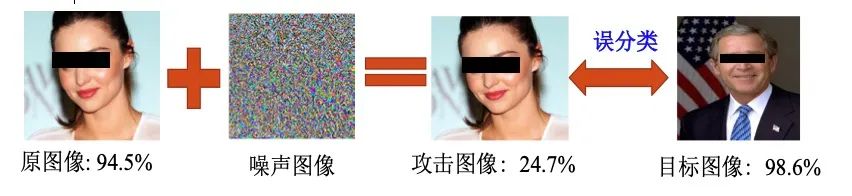

图1 深度学习的对抗性攻击

图1 深度学习的对抗性攻击本赛道将在清华大学人工智能研究院与瑞莱智慧联合自主研发的深度学习对抗性鲁棒开源平台ARES (Adversarial Robustness Evaluation for Safety)上进行,相关的代码、教程可以通过https://github.com/thu-ml/ares下载。

l参赛选手需要首先安装ARES软件包,具体方式如下

git clone https://github.com/thu-ml/ares

cd ares/

pip install -e .

l安装完软件包之后,可以非常方便的尝试运行不同的攻击算法,实现对深度学习模型的攻击

#import whatever benchmark you want

fromares.benchmark.distortionimport DistortionBenchmark

fromares.model.loaderimport load_model_from_path

fromares.datasetimport cifar10

session=...# load tf.Session

model= load_model_from_path('path/to/the/model.py').load(session)

dataset= cifar10.load_dataset_for_classifier(model, load_target=True)

# read documentation for the benchmark for all parameters

benchmark= DistortionBenchmark(attack_name='mim', model=model,...)

# config the attack method

benchmark.config(decay_factor=1.0)

result= benchmark.run(dataset, some_logger)

更多不同算法的相关比较可以参考论文:

Y. Dong, Q. Fu, X. Yang, Tianyu Pang, Hang Su, Zihao Xiao, Jun Zhu. Benchmarking Adversarial Robustness on Image Classification, in CVPR2020.

赛道二:ImageNet无限制对抗攻击

目前对抗攻击多数是通过在输入上增加Lp-Norm限制的微小扰动获得(即限制篡改后样本和原图之间的Lp距离)。这个做法虽然保证了扰动的不可见性,却很大限制了对抗样本生成的自由度。

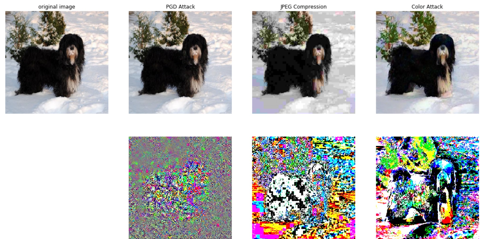

例如下图所示,第一行分别是原图,PGD attack,JPEG Compression Attack,以及ColorAttack,这三种攻击形态都保持了语义不变(视觉上看不出变化),JPEG压缩和ColorAttack其实改变了很大像素值(第二行所示)。所以,在实际生活中,攻击者在制作对抗样本时可任意篡改不受限,研究在不受限扰动下的对抗样本更具有现实意义。

图一不同对抗样本类型

本次比赛旨在探究更贴近实际且攻击性更强的生成无限制对抗扰动的方式。同时通过多种无限制攻击测试帮助理解当前深度模型脆弱之处并构建更鲁棒的分类服务。

为了更真实地模拟现实生活中的攻击场景,我们举办了本次ImageNet无限制对抗攻击竞赛,本次比赛不限制选手提交样本的扰动大小,自由度更大,也提供给选手更大的发挥空间。在评价标准设计上,我们采用了结合客观指标和主观指标的方式使得评价更加公平和科学。

首先,在比赛初赛和复赛阶段,采用了三个客观指标:样本的攻击成功率Attack Success Rate(ASR),图像自然性指标(FID),感知距离(LPIPS),来计算客观指标。由于图像语义度量一致是CV领域的一个难点,目前没有非常准确率的模型来语义改变程度。

为了更加科学地对算法进行衡量,我们进一步引入主观指标,主观指标分由打标人员从图像语义改变和图像质量两方面的审核结果决定,主观指标的引入使得对抗样本在肉眼感知上是有效且高质量的,这也充分保证了评测的公平性和科学性。

赛道二冲榜攻略:

寻找迁移性较强且最大程度上维持图像质量的扰动是破题点,我们鼓励选手用尽量多且丰富的模型进行自测,因为在初赛和复赛会使用不一样的后台模型,攻击的迁移性是至关重要的。

其次,我们不建议通过预测后台模型的方式,过拟合客观分指标,虽然此类方案能维持图像质量,获得较高的客观分,他们很容易在复赛后台模型被替换后失效。

我们推荐的解题方案是优化一种可叠加到图像上的通用扰动,并最大维持叠加后的图像质量。另外使用生成模型重构或者迁移图像也是一种可选方案。总结三点

1、不要试图通过黑盒迁移攻击的方式来提交样本

2、不要试图去过拟合客观机器打分指标

3、不要引入其他语义信息

丰厚奖励都有啥?

比赛时间:

报名及实名认证:2021.3.24结束

正式赛:2021.3.31结束

激励奖金:

挑战者计划第二季总奖金池为200万元,本期总奖金为10万美金,并包含近10万元的奖品福利

Pioneering Award:比赛思路发表高水平学术论文,前两位获得1万元现金。

奇思妙想奖:阿里巴巴20周年限定勋章礼盒(奖励给思路有创意的同学,上不设限)。

荣誉证书:前十名队伍和奇思妙想奖,都将获得阿里、清华、UIUC共同颁发的顶级证书。

线下颁奖:优秀队伍将有机会受邀参加6月的CVPR2021线下会议,并在国际舞台担任speaker分享思路。

绿色通道:总成绩排名Top20的队伍,可获得阿里安全校招绿色通道。

二次元双周榜:四轮双周榜,奖励头部战队和进步突出战队-绝赞手办。

邀请好友奖:邀请同学好友报名参赛,可获得RTX或者iphone12一台。

❤️

AI 安全系统的建立将是一场旷日持久的战事,将是一场属于无数梦想家的荣耀远征。

也许这场安全 AI 挑战赛,也正是为了在人海茫茫中找到这些同行的人。虽然真正改变时代的人也许还在襁褓之中,但梦想者的每一次相互搜寻,都意义非凡。

阿里安全首席架构师钱磊表示:「在阿里安全,基于复杂业务场景的攻防对抗几乎每天都在发生。当数字技术正在构建前所未有的新世界,阿里安全团队面对的是互联网企业中最丰富的业态和风险,毫无疑问,这是训练和提升人才专业能力最好的练兵场。」

清华大学教授朱军评价说:「安全 AI 挑战者计划是我们针对目前机器学习算法鲁棒性不足、容易受到恶意攻击的问题,主动地挖掘目前机器学习算法的安全漏洞,以期构建更加安全和可信的 AI 系统的一次尝试。我们希望通过这种努力,发展新的机器学习算法,并逐步将 AI 的安全问题体系化、标准化,逐渐形成一个优秀的线上社区,凝聚对抗样本乃至 AI 安全方面的研究者与开发者,通过大家的共同努力提升机器学习算法的安全性和可靠性。」

安全AI系列B站直播还有两场,详情如下

![[图]毅力号再传新图:展示下降过程中撞击火星表面扬起的烟尘](https://n.sinaimg.cn/spider2021225/335/w700h435/20210225/39dd-kkmphpt0374161.jpg)