原标题:拒绝后门:公开信呼吁苹果停止实施CSAM虐童图像检测系统 来源:cnBeta.COM

在苹果周四宣布了基于本机 AI 处理的“儿童受虐材料”(简称 CSAM)特征图像检测系统之后,行业专家与隐私倡导机构已纷纷表达了担忧和反对意见。尽管苹果的初衷很是积极正面,但这项技术也有着两面性,乃至向别有用心者敞开一个难以被封堵的后门。最新消息是,业界多方已经向苹果送去了一封公开信,呼吁该公司停止实施计划中的 CSAM 系统。

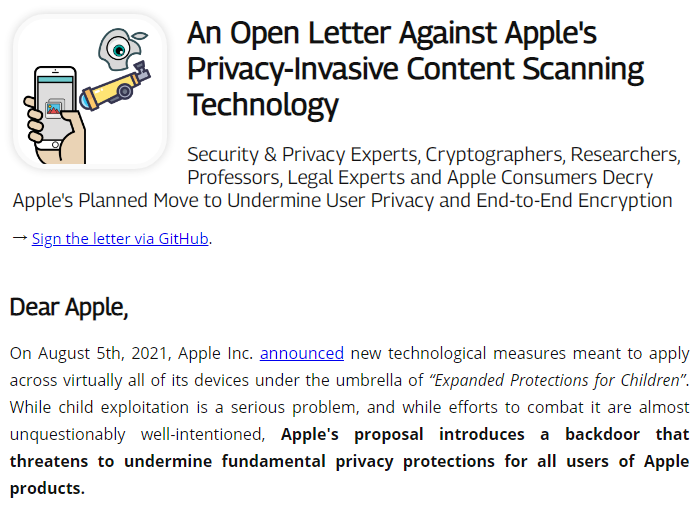

Apple Insider 指出,与其说是一封公开信,这份文件读起来更像是一份起诉书。其先是简要介绍了苹果周四发布的公告,然后认真剖析了即将推出的 CSAM 检测功能。

据悉,经过多方面的努力,苹果 CSAM 系统可利用本机算力,检测并上报传输到 iCloud 上的“违规内容”、以及保护儿童免受通过消息传递服务分享的敏感图像的侵害。

然而 Apple Privacy Letter 公开信中写道:“尽管虐童是一个很严重的问题,且针对此类违法行为的打击是绝对正义的。但苹果提议的这套 CSAM 方案,还是在系统中引入了一个后门,且最终可能破坏对所有苹果用户的基本隐私保护承诺”。

具体说来是,苹果 CSAM 系统会将用户照片与数据库中已知的文件哈希值进行匹配。该过程会在将文件上传到 iCloud 之前,于设备端完成。

其次是利用设备上的 AI 功能,来保护 17 岁以下儿童免受消息传递服务中的色情图片的困扰。有需要的家长,可在 13 岁以下儿童收发此类内容时收到警告通知。

然而据这封公开信所述,苹果暴露的最大问题,就是绕过了原本旨在加强用户隐私的端到端加密方案。这样就算苹果公开承诺新协议不会导致其软硬件留下后门,公众的信任度也会在顷刻间崩塌。

最后,这封公开信还汇集了一系列专家评论。比如很早的时候,约翰·霍普金斯大学密码学教授 Matthew Green 就对苹果的这项措施表达了担忧,另有 19 个组织和 640 名个人在 GitHub 上添加了相关署名标记。

最后,在呼吁苹果停止实施 CSAM 的同时,这封公开信要要求苹果发表一份新声明,以重申其对于端到端加密和用户隐私保障的承诺。