来源:机器之心

编辑:陈萍、小舟

在 2021 年计算机视觉与模式识别大会上,特斯拉 AI 高级总监 Andrej Karpathy 分享了一些特斯拉在过去几个月中所做的事情,会上 Karpath 阐明了特斯拉在自动驾驶领域的重要性,并介绍了该公司的最新超级计算机等相关内容。

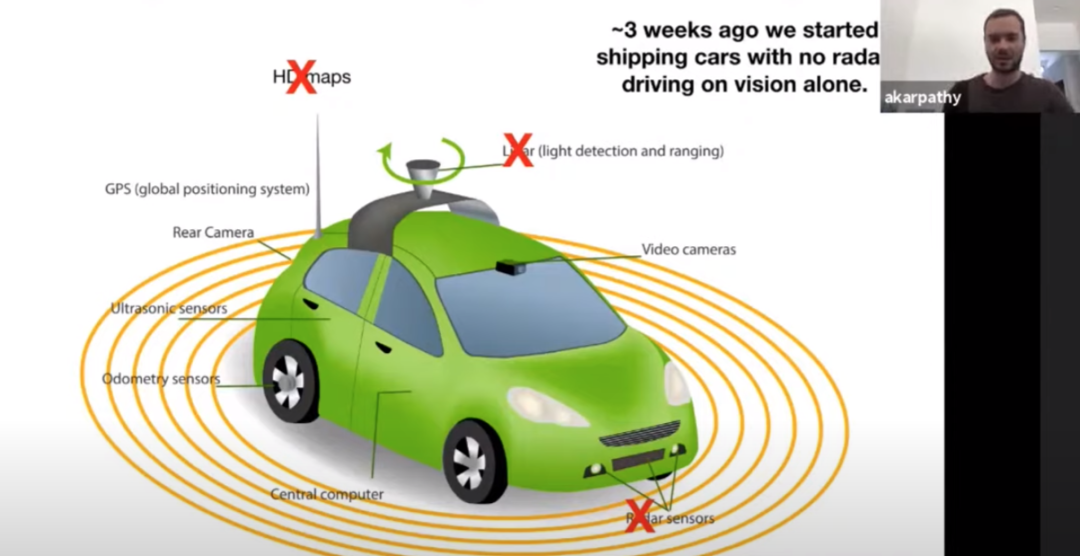

在自动驾驶领域,传感器的问题一直分为视觉派和激光雷达派。特斯拉 CEO 伊隆 · 马斯克是坚定的视觉派,他曾多次 diss 激光雷达,认为它「很荒唐,注定要失败」。

近日,在 CVPR 2021 线上自动驾驶研讨会(WAD)上,特斯拉人工智能高级总监 Andrej Karpathy 发表了主题演讲,揭秘了特斯拉如何训练 100% 的纯视觉自动驾驶神经网络。

在演讲中,Karpathy 谈到了特斯拉在过去几个月中所做的一些事情。首先他阐明了特斯拉在自动驾驶领域的重要性,并指出:当前「社会交通方面状况不佳」,指的是这些由金属制成的车辆在人类的控制下以高动能快速行驶——或者就像他所描述的:受人肉(Meat computer use in today’s transportation)控制。

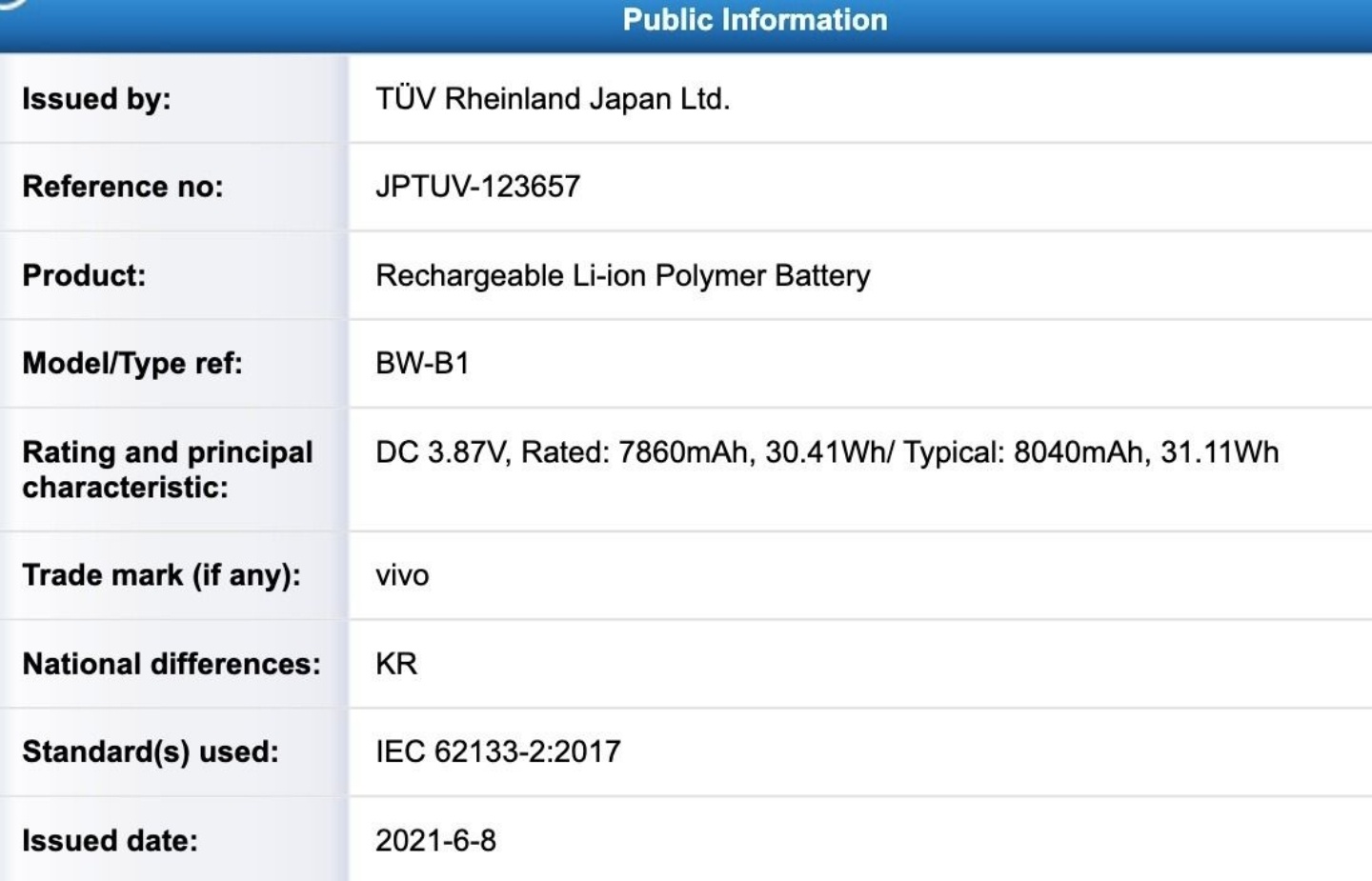

此外,Karpathy 还透露了该公司的最新超级计算机。该计算机允许汽车制造商放弃雷达和激光雷达等辅助设备,完全依赖高质量的光学摄像机实现自动驾驶。

Karpathy 阐述了目前交通环境中「人类驾驶员」的几个简单事实:

人们通常以 80mph 的速度驾驶重量大约一吨的汽车,可能存在 250ms 的反应延迟,而驾驶员需要转头和使用后视镜来查看交通状况,有时他们甚至不能注意力完全集中。此外,调查发现:

全球每天有约 3700 人死于车祸;

交通运输成本较高。

Karpathy 表示:「归根结底是人本身并不擅长驾驶,会造成一些交通事故。我们希望实现交通自动化,并让整个人类社会受益。」

他指出,使用计算机芯片代替人类驾驶在安全性和便利性方面都有很多好处:

同样以 80mph 的速度为例,使用计算机芯片控制驾驶,反应延迟<<100 毫秒,可以进行 360 度的感知,并且「计算机驾驶员」在驾驶过程中是全神贯注的。因此,自动驾驶未来会减少交通事故,并大幅降低交通运输成本。

特斯拉的独特之处

Karpathy 进一步阐述了特斯拉在自动驾驶方面的独特之处:「我们采取循序渐进的方法来实现自动驾驶。特别是我们已经拥有了使用 Autopilot 包的客户和数百万辆汽车,Autopilot 软件一直在运行,并完善了一些保障安全的功能,当然也包括 Autopilot 功能。在我们为客户提供安全和便利的同时,我们的团队正在开发完全自动驾驶(Full Self-Driving,FSD)功能。」

Karpathy 在演讲中播放了一段演示自动紧急制动的视频。当司机开过一个十字路口时,一个行人突然出现了。汽车检测到行人后,目标检测启动,猛踩刹车以避免碰撞。

下一个演示是一个交通管制警告的例子,该例子显示司机分心了,他可能在看手机,没有因为前面的红绿灯变红而刹车。而车子检测到了红灯,因此它发出警告声,司机开始减速。

接下来的两个视频是踏板误踩补救机制 (Pedal Misapplication Mitigation,PMM) 的示例。在第一个示例中,驾驶员正在停车并试图转弯。然而,他犯了一个错误踩下油门而不是刹车。此时自动驾驶系统启动,检测到行人,突然刹车。

Karpathy 展示的最后一个场景是另一个司机试图停车。司机向右转,以为在踩刹车然而他踩的是油门,此时系统启动制动,阻止了事故的发生。

Karpathy 还展示了特斯拉在旧金山自动导航的另一个视频,并指出他展示了所有的预测——你可以看到的线条和物体,表明系统也看到了相同的东西。

这些都说明计算机控制的自动驾驶能够比人类驾驶员做得更好,Karpathy 说:「作为工程师,我们当然会推广自动驾驶,对我们来说,零干预驱动实际上是相当常规的,尤其在人口稀少的地区。」

值得注意的是,特斯拉不同于其他自动驾驶公司,他们采用的是纯视觉系统。

视觉 VS 雷达,该选哪一个

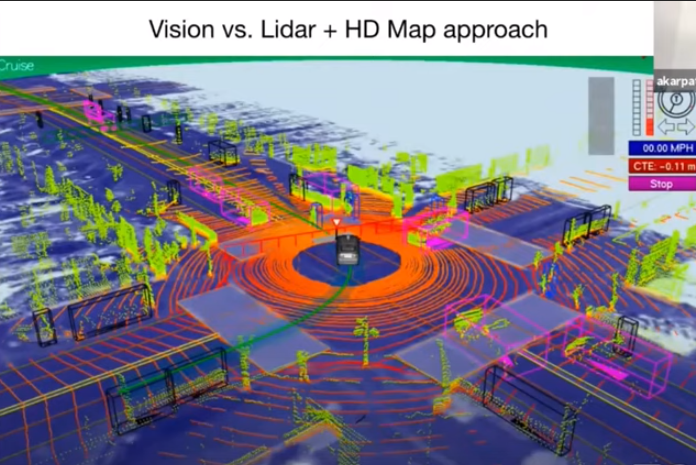

「这是一个在十字路口左转的 Waymo,这个视频为什么这么令人印象深刻?我想强调的一点是,尽管视觉和雷达两种情况看起来是一样的——有一辆车在十字路口左转,但就系统的可扩展性而言,情况却大不相同。」Karpathy说道。

所以,行业中很多竞争的方法都采用了这种激光雷达 + 高清地图的方法。

Karpathy 解释说,使用雷达的系统必须用激光雷达传感器预先绘制环境地图,同时还要制作高清地图。他们还必须插入所有的车道,红绿灯,在测试时,车辆需要定位到地图上,以便驾驶。

而特斯拉则不同,Lidar 和高清地图都不用,专注以相机为主的纯视觉感知方案:

雷达传感器已经广泛地应用在很多乘用车和卡车当中,通过无线电波技术,即便在能见度差的情况下也能检测快速接近的物体,是为汽车驾驶安全提供保障的传感器之一。但特斯拉公司表示北美市场的 Model 3 和 Model Y 车辆的辅助驾驶 AutoPilot 系统中,将放弃使用雷达传感器,转而聚焦摄像头视觉为中心的解决方案。他们将依靠摄像头视觉系统和神经网络处理来实现「Autopilot、全自动驾驶(FSD)和某些主动安全功能。」

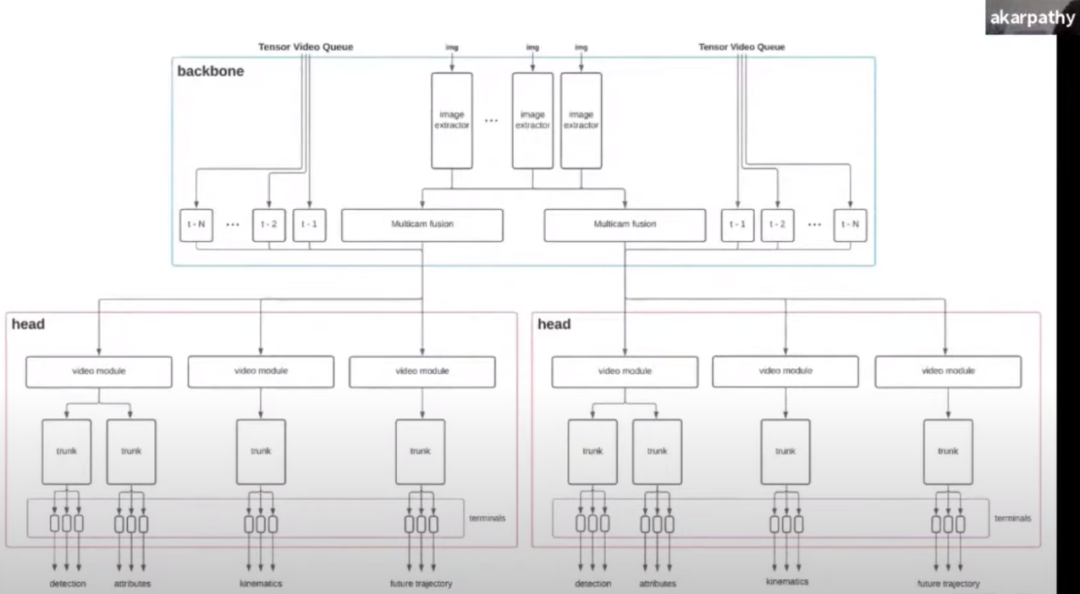

Karpathy 说:「我们采取的方法主要是基于视觉,依靠 8 个环绕车身并能够覆盖 360° 的摄像头。所以我们第一次来到一个十字路口,我们必须弄清楚车道在哪里,它们如何连接,交通灯在哪里,哪些是相关的,什么交通灯控制什么车道,所有的事情都发生在当下,发生在那辆车上,我们之前并没有高清地图等信息。」

Karpathy 表示这是一种更具可扩展性的方案,基于此他们需要一个能够预测速度、加速度等信息的神经网络,首先需要一个满足以下条件的数据集:

包含数百万视频的大型数据集;

经过预处理,带有多种标签的高质量数据集;

该数据集要丰富多样,包含一些边缘样例。

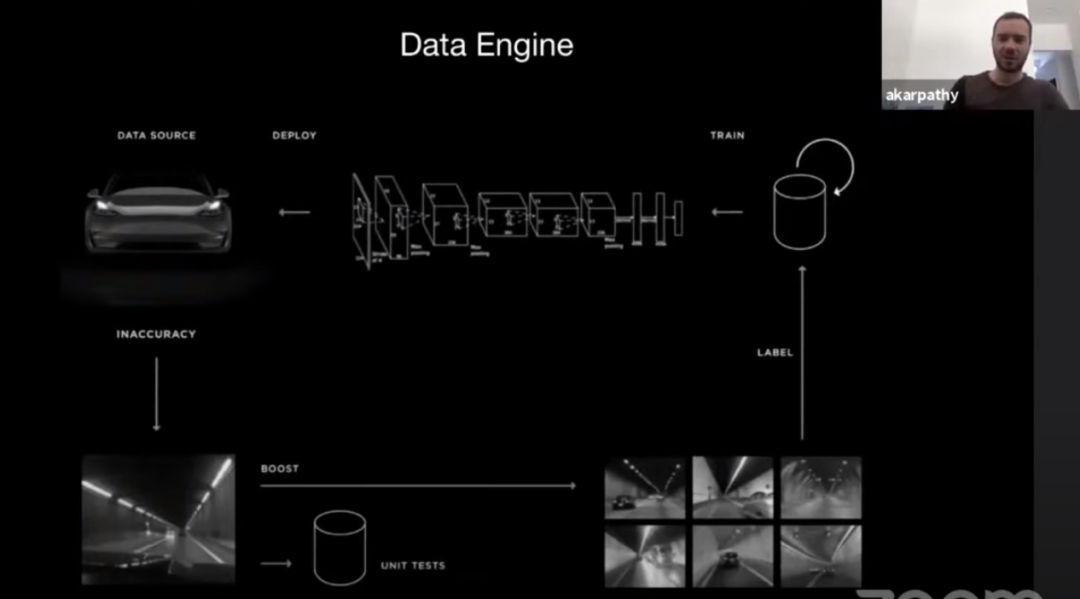

Karpathy 进一步介绍了特斯拉的数据引擎:

最终他们得到了一个包含一百万条视频,60 亿对象标签的数据集,该数据集后续还将继续完善更新。

接下来,研究团队需要在这个超大型数据集上构建一个神经网络。这个神经网络将是一个通用的视觉系统,原则上可以部署在任何需要的地方。这也是特斯拉研发团队正在做的事情。

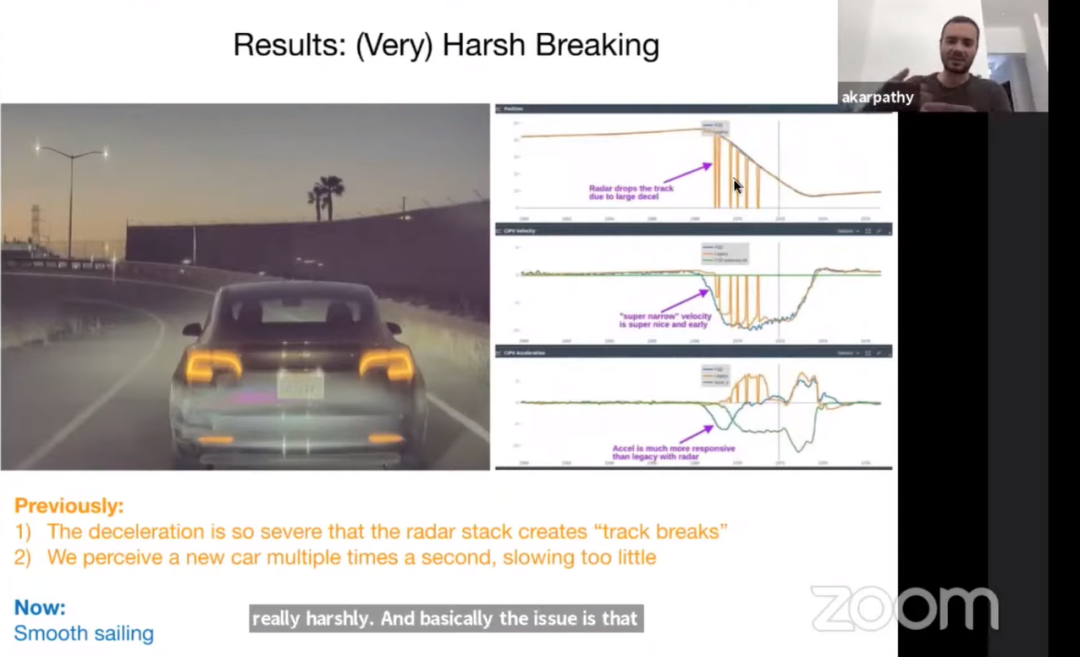

使用上述方案,特斯拉能够规避「突然减速」问题和基于雷达的系统的信号中断,提供平稳的驾驶状态。

Karpathy 解释说,特斯拉在过去几年里构建的视觉系统非常好,比其他传感器都要好。摄像头承担了感知方面的大部分工作,现在特斯拉正在移除一些传感器,因为这些传感器正在成为不必要的辅助。

「三周前,我们开始运送完全没有雷达的汽车。我们脱离了雷达,只靠视觉驾驶这些车。而我们这样做的原因,正如伊隆在推特上所表达的,『当雷达和视觉不一致时,你相信哪一个?视觉的精确度要高得多,因此,与其进行传感器融合,不如在视觉方面加大投入。』」

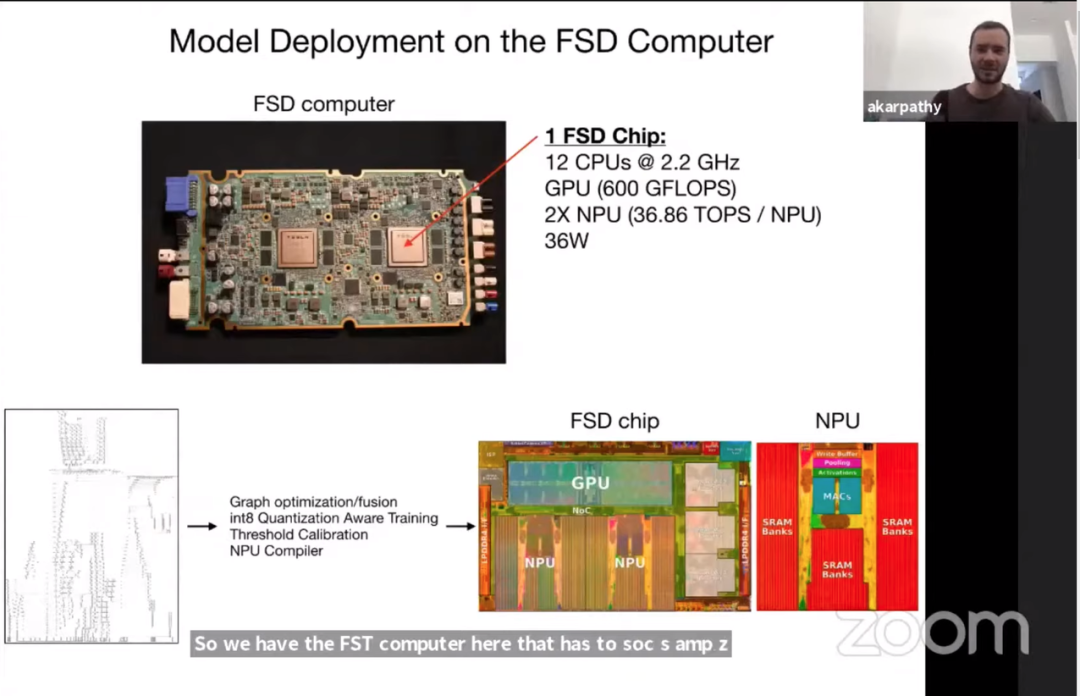

在演讲中,Karpathy 还展示了特斯拉完全自动驾驶(FSD)芯片:

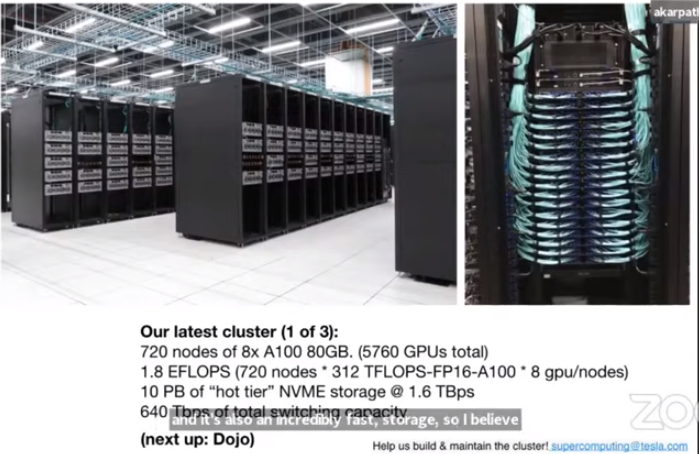

此外,Karpathy 还讲解了特斯拉的超级计算机集群,也是特斯拉即将推出的新超级计算机 Dojo 的「先行版本」。特斯拉声称该新集群具有一些相当疯狂的参数,应该会使其成为全球第五的计算机:

720 个 80GB 8x A100 节点(共 5760 个 GPU);

1.8 EFLOPS(720 节点 * 312 TFLOPS-FP16-A100 * 8 gpu / 节点);

10 PB「热层」NVME 存储 @ 1.6 TBps;

总交换容量为 640 Tbps。