原标题:赛迪智库|算法滥用的社会危害及监管建议

算法是数字社会发展的重要基石,通过将人们解决问题的逻辑、经验等以代码形式固化,建立起基于人工智能技术网络平台运行的一系列规则。随着数据挖掘、人脸识别、人机交互等技术在经济社会的深入应用,算法的渗透力和影响力日趋强大,一旦被滥用,很可能带来严重的社会危害。欧美等国家和地区高度重视算法治理,中国也有必要加强探索并建立算法治理规则,推动数字社会规范健康发展。

一、算法滥用带来严重的社会危害

滥用数据分析和算法推荐,侵害消费者合法权益。

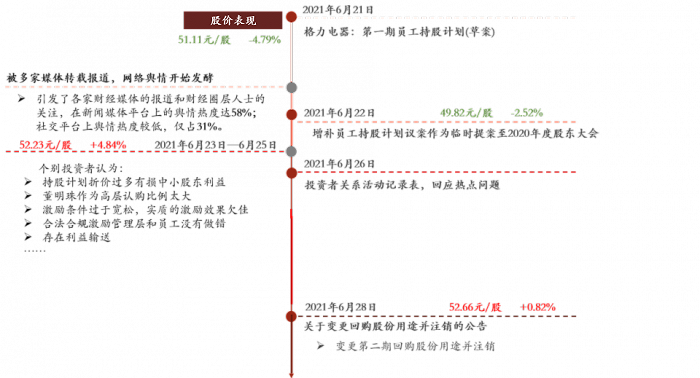

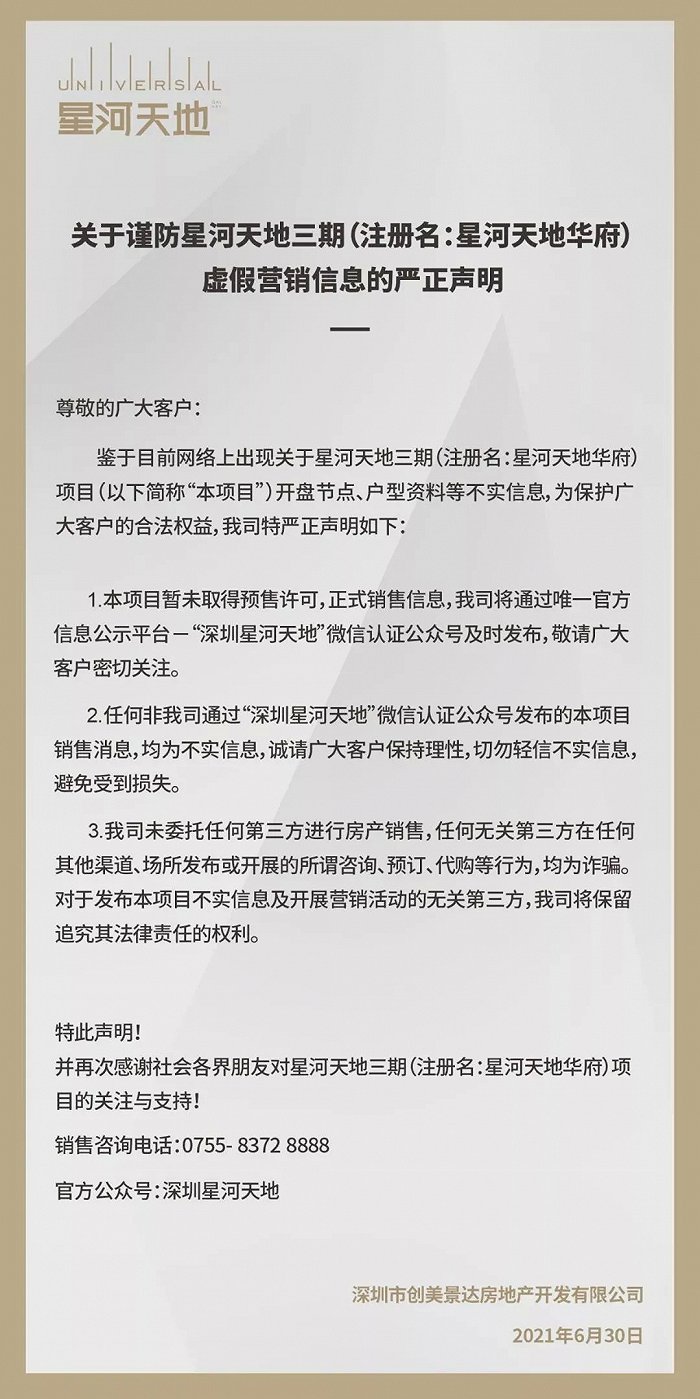

主要有三种表现形式:一是大数据杀熟。通过数据和算法实施价格歧视,对不同用户采取不同的价格政策,新老用户不同价、不同地区用户不同价、浏览量多或少的用户不同价,追求自身利润最大化。二是致瘾性推荐。通过数据和算法向用户进行个性化推荐,推荐其感兴趣的内容,且不论这些内容是否恰当、适合,有些内容甚至违背法律和公序良俗,从而使用户沉迷致瘾。三是影响和误导消费者。通过数据和算法对流量分配、搜索排名、评价等级设置障碍,限制经营者开展交易,降低消费者选择的可能性,进而引导和左右消费者选择。

利用算法实现利益侵占,压榨平台商家和从业者。

利用算法对依赖平台的经营者和从业者进行管理,设计算法时以平台利润最大化为核心价值,侧重算法逻辑,较少考虑人性,并将经营者和从业者“异化”为简单的数据、商品和工具。以被国内媒体广泛报道的相关外卖平台为例,平台通过分析外卖骑手的配送时间等数据,在没有统筹考虑天气、交通拥堵等外部因素的情况下,通过算法确定了外卖骑手的服务标准并以新标准约束骑手。骑手的超时率等指标一旦不符合设定标准,其收入将直接受到影响,同时还会影响其所在站点包括站长、人事、质控等在内的所有人员的收入。

基于缺陷数据集训练算法,导致算法偏见和不公平决策。

算法是由数据训练出来的,给它什么样的数据,就可能产生什么样的结果,如果训练算法的数据集存在包容性问题,则算法不可避免会产生偏见。例如,国外有科学家研究发现,由于较多采用男性和浅色人种的相关数据集,IBM、微软等企业的人脸识别产品存在着不同程度的女性和深色人种“歧视”,女性和深色人种的识别正确率显著低于男性和浅色人种,最大差距可达34.3%。算法偏见还会导致不公平决策,而且算法决策不公开、不接受质询、不提供解释、不予以救济,进一步加深了社会不平等。例如,英国达勒姆警方使用了数年的犯罪预测系统,将黑人是罪犯的概率定为白人的两倍,把白人定为低风险、单独犯案人群;美国密歇根州失业保险局的融合数据自动化系统则利用算法审核失业补贴申请者,以此决定申请者是否存在欺诈行为并施加处罚,但该系统93%的出错率导致4万人受害。

二、欧美国家开展算法治理的举措

推进算法公开,提升算法透明度。

从欧美国家的实践看,算法公开主要有三个层次:一是披露算法采用情况等相关信息。欧盟《通用数据保护条例》第13条规定,当数据控制者收集个人数据时,如采用自动化决策对用户进行画像或存在类似情况的,应当向数据主体提供关于此类问题处理的逻辑及预期后果的有效信息。二是解释算法决策的原理和逻辑。美国《公平信用报告法》包含“不利行动告知”条款,要求贷款方就对金融消费者不利的算法评分向其进行解释。为此,一些机构已在制定指南,比如2020年5月英国信息专员办公室与阿兰图灵研究所共同发布《人工智能决策说明指南》。三是公开算法源代码。2016年美国纽约州尝试通过立法,要求政府机构披露其算法产品采用的源代码,遭到算法产品相关服务商的强烈反对。

建立算法问责制,强化算法损害的可救济。

算法问责强调的是对算法运行结果负责,要求算法运营者采取措施确保算法按照 预期运行,并建立确定和纠正有害后果的机制。目前,美欧等国家和地区对算法问责制的探索主要集中在几个方面:一是算法影响评估。2019年4月美国发布的《算法问责法案(草案)》规定,算法影响评估是指对算法及其开发过程的评估,以衡量其在设计和训练数据中,对准确性、公平性、偏见、歧视及对隐私和安全的影响。二是算法准确性和偏见测试。2019年3月美国发布的《商业人脸识别隐私权法案(草案)》规定,使用人脸识别技术的实体,应当提供一个应用程序编程接口,使至少一名合法从事独立测试的第三方能够对人脸识别技术的准确性和偏见进行合理测试。三是赋予数据主体对算法损害结果的救济权利。欧盟《通用数据保护条例》第22条规定,如果某种自动化决策会对数据主体产生法律效力或对其造成类似的重大影响,数据主体有权不受上述决策限制。2020年6月美国发布的《数据问责和透明度法案(草案)》规定,个人有权质疑收集数据的理由并要求对自动化决策进行人工审查。

加强算法伦理建设,提升算法公平性。

欧美国家十分重视算法伦理建设。一是将算法伦理建设作为发展人工智能的重要任务。美国2019年修订了《国家人工智能研究与发展战略计划》,提出包括应对伦理、法律和社会影响、确保人工智能系统安全等八项战略重点。欧盟2020年2月发布的《人工智能白皮书》,明确了欧洲人工智能必须以欧洲价值观和包含人类尊严和隐私保护等在内的基本权利为基础,并将伦理监管作为重要政策目标。二是制定发布算法伦理指南,为科技企业提供价值导向。2018年4月,英国议会发布《英国人工智能发展计划、能力与志向》,提出了“人工智能不应用于削弱个人、家庭乃至社区的数据权利或隐私”等5项人工智能基本道德准则。2019年4月,欧盟人工智能高级专家组发布《可信赖人工智能伦理指南》,明确提出尊重人类的主体性、避免伤害等适用于人工智能系统的4项伦理原则。三是推动行业自律。2017年阿西洛马会议发布了人工智能23条原则,霍金等近4000名专家和行业领袖签名支持。

三、几点建议

探索建立算法应用监管制度体系。

算法应用既有好的一面,也会因滥用带来潜在危害。中共中央印发的《法治社会建设实施纲要(2020-2025年)》提出,要制定完善的算法推荐、深度伪造等新技术应用规范管理办法,但目前中国尚未形成算法应用监管制度体系。建议组织开展算法应用调查,识别不同应用场景下的算法滥用危害,加快制定算法应用规则和标准规范,探索形成一系列的监管制度。

一是建立算法应用影响评估制度。

针对典型场景,要求企业在算法正式上线前,评估算法对消费者权益、个人基本权利等的影响,并针对评估中发现的相关风险,采取相应防范措施。

二是建立算法透明度制度。

企业要向监管部门和公众披露其采用算法的相关信息,包括采用目的、应用场景、算法技术实现等,对那些可能对个人和社会产生重大影响的算法决策,企业应解释算法的基本原理。

三是建立算法问责机制。

通过算法应用规则赋予个人对算法损害的救济权利,允许个人对算法决策提出异议、要求对算法决策进行人工审查等。

加强算法应用的安全测试与监测。

通过安全测试等技术手段防范算法滥用风险,是国外算法治理的重要组成部分。中国目前应做好以下工作:一是组织开展算法应用安全测试,定期评估算法的技术准确性和安全性,明确安全测试不通过的算法不得应用。二是利用大数据、人工智能等技术手段,加强对网络平台算法数据采集、运行过程、社会影响等方面的动态监测,强化事中监管,提高对风险的预测、防范和处置能力。

依托行业组织强化企业算法伦理建设。中国政府高度重视算法伦理问题。2017年国务院发布的《新一代人工智能发展规划》提出,要大力开展对人工智能行为科学和伦理等问题的研究,制定促进人工智能发展的伦理规范。目前国家新一代人工智能治理专业委员会已发布人工智能治理原则,建议做好以下工作:一是加快研究制定算法伦理规则,推动企业形成共识,为算法研发应用提供价值导向。在适当的时候,可将算法伦理规则转化为法律法规,增强对企业行为的约束力。二是支持设立算法社区、行业联盟等组织,依托行业组织指导企业建立内部治理框架、控制机制和责任体系,防止算法滥用;同时,积极探索开展企业行为评价,对企业的不道德行为予以公开,形成社会引导和示范效应。

(作者闫晓丽来自赛迪智库)