原标题:AI社会学|困在算法日常里的人,在算法里日常抵抗

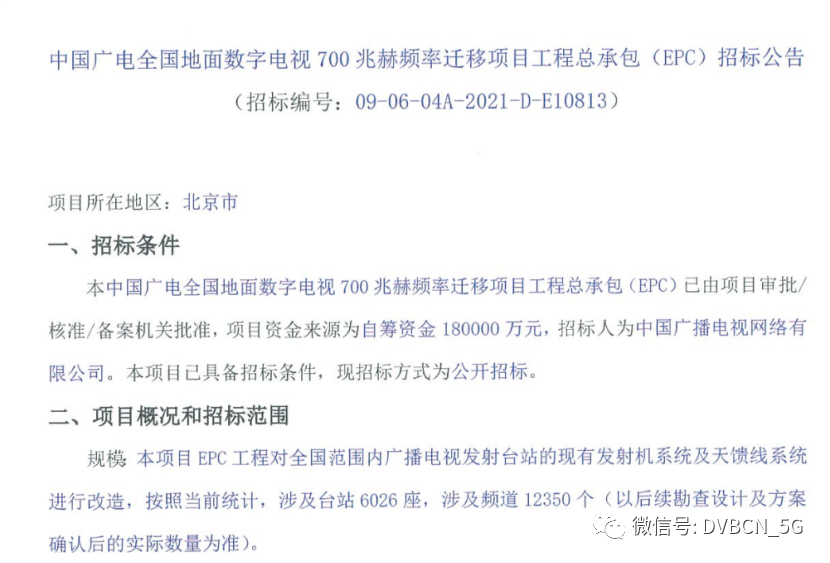

去年9月,一个名叫克林·麦德兰 (Colin Madland) 的白人,在推特上发布了一张与黑人同事视频通话的截屏。他原本只是想揭发相关视频会议软件Zoom的一个问题——在某种模式下,该软件算法无法识别麦德兰的黑人同事,并擅自将其“斩首”了。

Zoom将麦德兰的黑人同事“斩首”了

麦德兰没想到的是,当他截屏上传推特之后,在推特的手机端上,黑人同事干脆“消失”了,图片仅仅剩下身为白人的他自己。

截屏上传推特之后,麦德兰的黑人同事“消失”了

推特用算法在推特的手机端自动裁剪图片是常规操作,目的在于防止过大图片在寸土寸金的手机端占用太多页面空间,同时将用户的注意力集中到图片最重要的部分。关于麦德兰的图片,算法似乎做出了这样的判断——相对于黑人,白人是更重要的那一部分。

麦德兰的推文很快引爆了网络狂欢。网友们前仆后继、看热闹不嫌事大地对推特的图片裁剪算法进行了各种明暗条件下的反复测试,测试图片一度延伸到猫猫狗狗和毛绒玩具,直到某网友锤下棺材板上的最后一根钉子——在反复上传白人参议员米奇·麦康奈尔(Mitch McConnell)和黑人前总统奥巴马(Barack Obama)的照片后,该网友发现推特算法会在手机端不断裁剪掉奥巴马,而把麦康奈尔放在图片中央。

换句话说,推特的算法,犯了和ZOOM一样的毛病:种族歧视。

这些年,被网友集体抓包的网络平台不在少数。比如著名的谷歌。2015年,程序员阿尔西内(Jacky Alciné)将自己与朋友的合影上传到谷歌照片,讵料黑人朋友竟被标注为“大猩猩”。此后,热心网友竞相“调戏”对谷歌照片的脑残标签,直到2018年,谷歌“一劳永逸”地封禁了“大猩猩”、“黑猩猩”或是“猴子”的标签。

再如美国最大的点评网站Yelp。2017年,一群小企业主在对Yelp算法进行反复测试后发现,对于不使用该平台广告服务的企业,算法往往给出较低评分。被戳穿后,Yelp不得不对其算法进行了调整。

又如酒店预订平台缤客(booking.com)。2019年,一批用户发现缤客对某酒店的综合评分与他们给出的分数明显不符,发现问题后,他们联合起来,通过反复测试,证明了平台算法会在不透明的情况下调高某些低评分。

在最近的一篇论文里,我和合作者们把平台用户的这类“抓包”行为称为“日常生活里的算法审计”(everyday algorithm auditing)——平日里,由于算法的算计而受困其中的用户们,正在联合起来,通过集体智慧,对算法进行“反向分析”。

也就是说,平台们看似全知全能、无远弗届,但对于算法与人的真实互动及其结果,它们在很大程度上是无法事先知晓的。

正如推特的公关团队在“裁图事件”后解释的那样,“在模型发布前,我们的团队进行了反复测试,并没有发现种族或性别歧视的相关证据。但这些案例表明,我们还有更多的分析要做。”

各大平台可以聘用顶级机器学习专家和软件测试工程师,在算法上线前,对可能出现的漏洞进行检测,但即便是这些专家也永远无法预测,算法在与真实世界里的真实人生互动之后会发生什么。

其实早在1996年,在现代人工智能和机器学习系统大规模出现之前,巴特亚·弗里德曼(Batya Friedman)和海伦·尼森鲍姆(Helen Nissenbaum)就在他们那篇著名的短文《计算机系统里的偏见》(Bias in Computer Systems)里,就计算机系统里的“偏见”进行了分类:

一类是由社会历史原因造成的“预存偏见”(pre-existing bias)。比如,性别和种族歧视可能会在算法里持续显现。

一类是由当时当地技术限制等原因造成的“技术偏见”(technical bias)。比如,在1990年代,一种用来随机筛选稀缺药物接受者的算法可能会系统性地偏向数据库末端的病人。

还有一类是那些只有在与人类用户互动和日常使用的情境里展现出来的“突现偏见”(emergent bias)。比如,微软当年的人工智能聊天机器人Tay,与网友在推特上聊了不到24小时,就被“调教”成了一个“种族主义者”。

这也是为什么发现这些“突现偏见”的,往往不是平台巨资聘请的工程师、律师和第三方审计人员,而是那些日日夜夜受困在算法里的人们——

是真实生活里的真实人类在日常生活里对算法进行了千万次的测试,以肉身为道场,才把算法的漏洞暴露出来,钉上耻辱柱

。

这是我们对算法的日常抵抗。

1985年,耶鲁大学政治学和人类学教授詹姆斯·C·斯科特(James C. Scott)出版了名作《弱者的武器:农民反抗的日常形式》(Weapons of the Weak: Everyday Forms of Peasant Resistance)。这本书基于1970年代末他在马来西亚村庄塞达卡(Sedaka)所做的田野调查。

斯科特发现,自1970年代引入双耕制之后,马来西亚农村的贫富差距加剧,农民们的不满与日俱增,可奇怪的是,那里却很少发生有组织的、公开的抵抗。从传统政治学的角度来看,马来农民缺乏政治意识和自觉,也鲜少有意义的政治行动。

但作为人类学家,斯科特却察觉到一种不曾被书写的、不一样的“抵抗”:农民们在日常生活里,以自己独特的方式对结构性的不平等进行着“消耗战”,虽然看似微不足道,却也一点一滴地销蚀着凌驾在他们头上的统治机构。

这些日常形式的反抗,我们也许再熟悉不过了——偷懒、怠工、装糊涂、开小差,跟现在流行的的“躺平”“带薪蹲坑” “日常摸鱼”可谓异曲同工,一脉相承。

而这些,斯科特称之为“弱者的武器”(weapons of the weak)。

斯科特的立场,在80年代之后受到了许多批评——如果日常形式的抵抗无法引发结构层面的改变,而仅仅滞留在生活表面,那么这些“偷懒、怠工、装糊涂、开小差”到底有多少意义呢?这确实不好说。可以确定的只是,这些日常形式的抵抗至少表明个人和公众并不完全臣服于这些支配性的社会结构。

在人工智能的时代,在算法统治一切的世界里,这些日常抵抗包括用户们个人生活里的小动作和不配合——比如故意点击无关内容给推荐算法捣乱;在社交媒体上合力揪出算法的漏洞——比如,像本文开头那个例子,大家通过集体协作一起检测证明算法“种族歧视”,等等。

这些小打小闹不断给占据支配地位的算法制造麻烦,并提示我们:算法并不像我们所想象的那样无所不知、无所不能。即使渺小如我们,在某些时刻,也有反制算法的可能。

与此同时,另一种对算法的日常抵抗正在浮现。

去年7月,阿明·萨米(Armin Samii) 已经为“优步送餐” 工作了几个星期。在美国,“优步送餐”很多时候是由骑手骑行送达的。这一单,萨米接下的是算法估算为20分钟左右、1英里的工作。可事实上,送餐app却将他带上了匹兹堡最陡峭的山坡之一,在地图上看来是1英里的直线路程,实际耗费了4 英里的骑行。最终按照算法的逻辑,“优步送餐” 仅仅支付了他1英里的费用。

还好萨米是一名软件工程师。在发现优步算法的问题之后,他创建了谷歌浏览器的扩展程序“优步骗人” (UberCheats),帮助外卖骑手们收集算法“克扣”薪酬的证据。

萨米们想要追诉的权利。

还有一些困在算法里的人将他们的诉求告上法庭。根据欧盟的通用数据保护条例 (GDPR), 一群英国优步司机在阿姆斯特丹起诉了这家叫车公司。司机们表示,通过集体诉讼,他们获得了存储于平台之上的所有关于他们的个人数据,他们想知道,优步的评价体系是如何通过这些数据来给他们打分的。

司机们想要知情的权利。

36年前,斯科特在他那本引发巨大争议的书里说:

“日常形式的抵抗不会成为头条新闻……(然而)正如数以百万计的珊瑚虫制造出珊瑚礁一样,数以万计的个体不服从和逃避的行为也创造了自己的政治或经济堡礁。”

“Everyday forms of resistance make no headlines. Just as millions of anthozoan polyps create, willy-nilly, a coral reef, so do thousands upon thousands of individual acts of insubordination and evasion create a political or economic barrier reef of their own.”

不高估算法的魔力,不低估自己的力量。也许,最后能够抗衡算法的,正是我们这些困在算法里的人。

参考资料:

【1】Khristopher J Brooks. 2020. Twitter users say the platform crops out Black faces. https://www.cbsnews.com/news/ twitter-image-cropping-algorithm-racial-profiling

【2】Motahhare Eslami, Kristen Vaccaro, Karrie Karahalios, and Kevin Hamilton. 2017. “Be careful; things can be worse than they appear”: Understanding Biased Algorithms and Users’ Behavior around Them in Rating Platforms. In Proceedings of the International AAAI Conference on Web and Social Media, Vol. 11.

【3】Motahhare Eslami, Kristen Vaccaro, Min Kyung Lee, Amit Elazari Bar On, Eric Gilbert, and Karrie Karahalios. 2019. User attitudes towards algorithmic opacity and transparency in online reviewing platforms. In Proceedings of the 2019 CHI Conference on Human Factors in Computing Systems. 1–14.

【4】Shen, Hong, Alicia DeVos, Motahhare Eslami, and Kenneth Holstein. 2021. "Everyday algorithm auditing: Understanding the power of everyday users in surfacing harmful algorithmic behaviors." arXiv preprint arXiv:2105.02980.

【5】Friedman, Batya, and Helen Nissenbaum. Bias in computer systems. Routledge, 2017.

【6】Scott, James C. 1985. Weapons of the weak: Everyday forms of peasant resistance. Yale University Press.

【7】Aarian Marshall. 2021. Gig Workers Gather Their Own Data to Check the Algorithm’s Math. Wired. https://www.wired.com/story/gig-workers-gather-data-check-algorithm-math/

-----

作者沈虹,毕业于美国伊利诺伊大学香槟分校传播学系,现任职于美国卡内基梅隆大学。她用社会学的方法研究新兴科技。