来源:机器之心

自 2017 年 6月谷歌提出Transformer以来,它便逐渐成为了自然语言处理领域的主流模型。最近一段时间,Transformer更是开启了自己的跨界之旅,开始在计算机视觉领域大展身手,涌现出了多个基于Transformer的新模型,如谷歌用于图像分类的ViT以及复旦、牛津、腾讯等机构的SETR等。由此,「Transformer是万能的吗?」也一度成为机器学习社区的热门话题。

实例分割是计算机视觉领域的一项基础任务, 视频实例分割(Video Instance Segmentation, VIS)则需要对视频序列中的目标实例同时地进行分类、分割和跟踪。其中更具挑战性的是,研究人员需要对每个单独的帧执行实例分割,同时又要在连续帧之间建立起实例的数据关联,即跟踪。

在最近的一篇CVPR 2021 Oral论文中,来自美团等机构的研究者首个将Transformer应用到了端到端视频实例分割中,并提出了一个基于Transformer的视频实例分割新框架VisTR,该框架在所有使用单一模型的方法中实现了最佳效果和最快速度。

在机器之心最新一期的论文线上分享中,我们邀请到了论文一作、美团算法工程师王钰晴为大家介绍将Transformer应用于视频实例分割的技术细节。

欢迎大家报名参与,如有疑问可在QA环节与分享嘉宾交流。

主题:基于Transformers的端到端视频实例分割算法VisTR

嘉宾简介:王钰晴,南开大学硕士毕业,2019年加入美团。主要负责无人车中地图元素的目标检测和实例分割工作,以及围绕一阶段实例分割和视频实例分割相关的前沿算法研究。

分享摘要:本文是第一个将Transformers应用于视频分割领域的方法。视频实例分割指的是同时对视频中感兴趣的物体进行分类,分割和跟踪的任务。现有的方法通常设计复杂的流程来解决此问题。本文提出了一种基于Transformers的视频实例分割新框架VisTR,该框架将视频实例分割任务视为直接端到端的并行序列解码和预测的问题。给定一个含有多帧图像的视频作为输入,VisTR直接按顺序输出视频中每个实例的掩码序列。该方法的核心是一种新的实例序列匹配和分割的策略,该策略在整个序列级别上对实例进行监督和分割。VisTR将实例分割和跟踪统一到了相似度学习的框架下,从而大大简化了流程。在没有任何trick的情况下,VisTR在所有使用单一模型的方法中获得了最佳效果,并且在YouTube-VIS数据集上实现了最快的速度。

论文链接:https://arxiv.org/pdf/2011.14503.pdf

项目链接:https://github.com/Epiphqny/VisTR

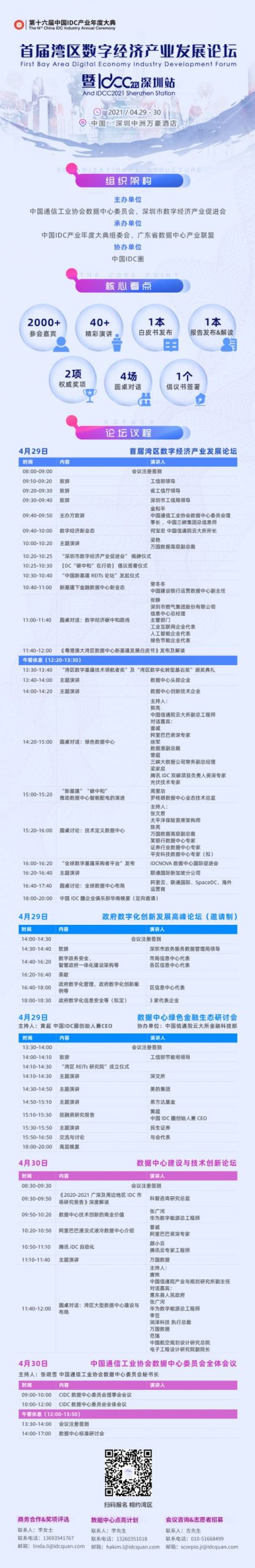

时间:北京时间4月14日19:00-20:00

直播间:https://jmq.h5.xeknow.com/s/LlECz

直播交流群

如群已超出人数限制,请添加其他小助手:syncedai2、syncedai3、syncedai4 或 syncedai5,备注「分割算法」即可加入。