来源:机器之心

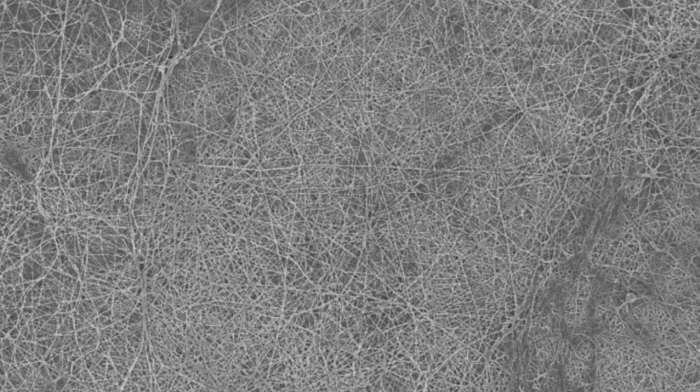

2017 年,谷歌大脑的研究者们在论文《Attention is All You Need》中首次提出了一种基于自注意力机制的 Transformer 模型,该模型在语义特征提取、长距离特征捕获、任务综合特征抽取等自然语言处理方面表现出了更优的性能,并在自然语言处理、人机对话、图像处理等许多领域都达到了当时的 SOTA 水平。

自论文问世以来,引入 Attention 机制的 AI 模型便在自然语言处理、语音识别等 Seq2Seq 序列任务上表现出了显著的性能提升。基于 Transformer 的 NLP 模型也出现了井喷式增长,如 OpenAI 先后推出的 GPT、GP-2 和 GPT-3,谷歌推出的 BERT,Facebook 推出的 XLM/XLM-R、BART 等。最近,Transformer 也成功地跨界到了计算机视觉(CV)领域,并先后涌现出了 DERT、ViT 和 SETR 等模型,在超分辨率、图像识别和物体检测中取得了 SOTA 性能。

但应该看到,随着时间的推移,基于 Transformer 架构的 AI 模型规模越来越大,参数也越来越多。Open AI GPT-3 模型的参数更是达到了史无前例的 1750 亿,由此对计算和存储提出了更高的要求。相应地,如何更有效地结合 Transformer 模型特点和 GPU 硬件加速,进而充分释放并行计算能力实现极致加速成为非常重要的研究课题。

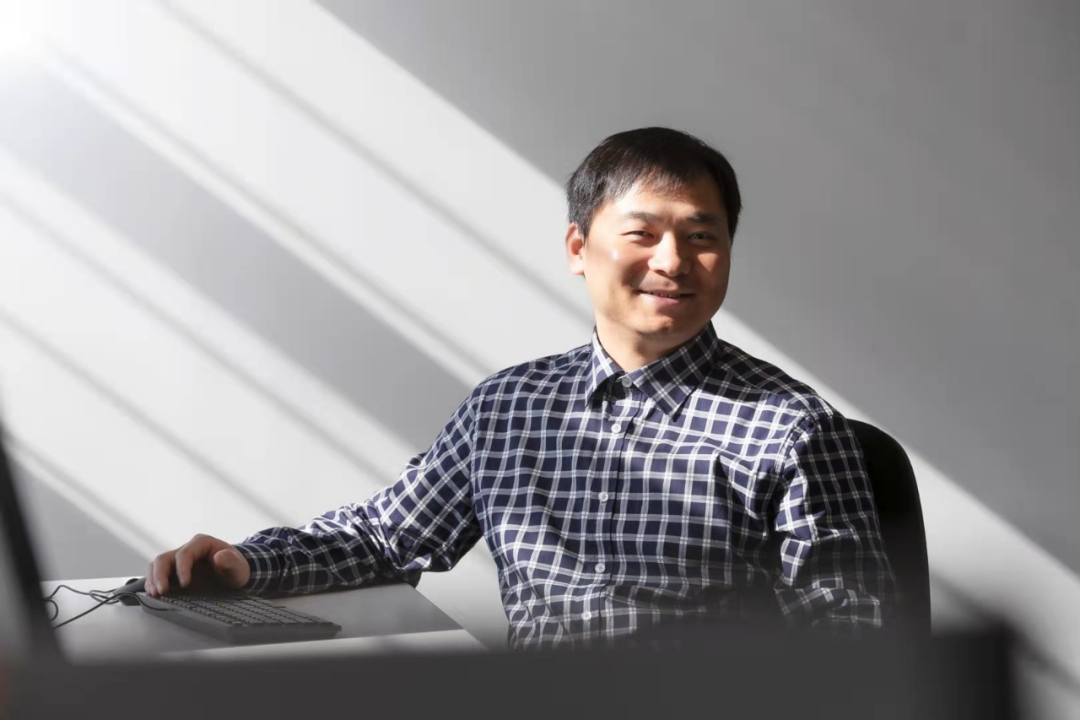

3 月 11 日,机器之心最新一期线上分享邀请到了快手美国研究中心异构计算实验室的视频算法架构师任永雄,为大家详细解读 Transformer 模型在 GPU 上的深度优化。

分享主题:Transformer模型在 GPU 上的深度优化

个人简介:任永雄于 2016 年在南加州大学获得电子工程博士学位,研究方向为数字信号处理。在此之前,他分别于 2011 年和 2008 年在北京大学和北京邮电大学获得电子工程的硕士和本科学位。任永雄博士目前就职于快手美国研究中心异构计算实验室,担任视频算法架构师,主要研究方向为深度学习模型的硬件加速和优化。他目前为止发表了超过 130 篇期刊和会议论文,其中第一作者文章超 25 篇,国际顶级会议特邀报告 4 次,Google Scholar 引用超过 10000 次。他的 publication 包含:2 部书本章节,4 份 MPEG 标准提案,25+ 个美国专利及申请,60+ 篇期刊论文,70+ 篇会议论文。他是 2014 年 IEEE Globecom 最佳论文的获得者,同时获得其他多项 IEEE 和 SPIE 的奖项。他的研究兴趣包含深度学习、数字信号处理、图像处理和硬件体系结构。

分享概要:从 Google 在 2017 年发表著名的「Attention is all you need」文章开始,Transformer 架构就开始攻占 AI 的多个领域:不仅成为 NLP 和语音等场景的默认核心架构,同时也成功跨界到计算机视觉方向。然而 Transformer 对计算和存储有着较高要求,使得很多 AI 模型在 GPU 上的大规模部署受到限制。如何针对 Transformer 模型结构特点,结合 GPU 硬件特性以充分释放其并行计算能力实现极致加速至关重要。本次直播我们将结合快手 NLP 和语音等 AI 应用分享如何在 GPU 上实现 Transformer 系列模型包含 BERT、GPT-2 和 Conformer 等的深度加速。

直播间链接:https://app6CA5Octe2206.h5.xiaoeknow.com/v2/course/alive/l_603e0560e4b087d11d4e28d6?app_id=app6CA5Octe2206&alive_mode=0&pro_id=&type=2

直播时间:北京时间 3 月 11 日 20:00-21:00

加入机动组,一起看直播

「机动组」是机器之心发起的人工智能技术社区,将持续提供技术公开课、论文分享、热门主题解读等线上线下活动,同时「机动组」也将不定期组织人才服务、产业技术对接等活动,欢迎所有 AI 领域技术从业者加入。