来源:机器之心

作者:Sharan Narang等

机器之心编译

编辑:魔王

来自 Google Research 的研究人员探索了多个 transformer 变体,发现它们无法在多个实现和应用中实现很好地迁移,大多数架构更改无法有效提升性能。

Transformer 诞生短短三年,已然风头正劲,不仅成为自然语言处理领域的主流预训练模型,还越来越多地应用于计算机视觉等领域。Transformer 架构变体层出不穷,但并未有研究证明它们能够在不同实现及应用中实现轻松迁移,而这也限制了其被更广泛地使用。

为了理解为什么最广泛的 transformer 应用不采纳这些架构更改,一支来自 Google Research 的团队在相同的实验环境下对它们进行了综合评估。研究者惊讶地发现,大部分 transformer 架构更改无法有效提升在下游 NLP 任务上的性能。

论文链接:https://arxiv.org/pdf/2102.11972.pdf

研究者首先在最常应用 transformer 的任务上重新实现和评估多种 transformer 变体,并使用以下两种 transformer 模型作为基线:在自注意力和前馈模块前使用层归一化;使用具备共享偏见的相对注意力,而不是正弦位置嵌入。该研究调查的 transformer 架构更改包括:

透明注意力:沿着编码器路径创建加权残差连接,以加速梯度流;

进化 Transformer:通过基于进化的架构搜索来设计模型,其中初始群体的种子是原版 transformer;

合成器变体:用「合成注意力」替代自注意力;

漏斗 Transformer:渐进式地减少序列长度,以高效编码输入序列;

稀疏专家 Transformer:用稀疏激活专家层替代前馈网络;

通用 Transformer:对输入序列重复应用相同的 transformer「模块」。

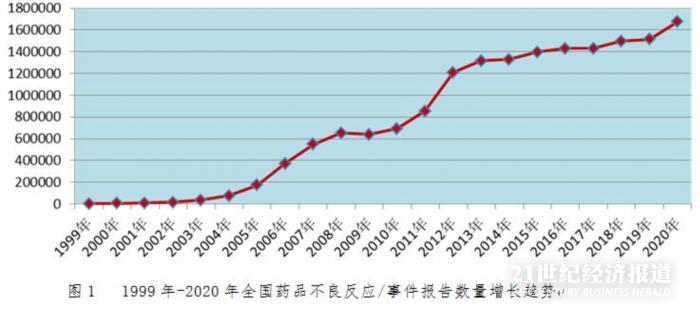

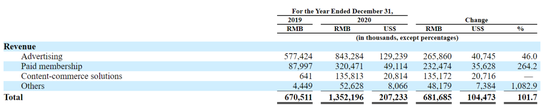

研究者在两个实验设置下进行性能评估,分别是基于 T5 的迁移学习,和在 WMT’14 英德翻译任务上的监督式机器翻译。实验结果参见下图:

所有 transformer 变体的结果。基线模型是具备相对注意力的原版 Transformer。SGLUE 表示 SuperGLUE;WebQ 表示 WebQuestions 数据集。

如上结果表明,带来显著性能改进的架构更改往往具备以下特征之一:更改相对较小、依靠增加参数量或者模型速度较慢、基于 Mesh TensorFlow 代码库创建。很少有架构更改会带来性能提升,这一发现与提出这些变体的研究论文中的实验结果相悖。

谷歌研究者进一步研究了对此的合理解释,得出结论:这些模型变体无法在不同实现和应用中实现高效迁移。

最后,该团队对未来如何提升架构更改的鲁棒性提供了一些建议:在多个完全不同的代码库中对提出的架构更改进行测试;将架构更改应用到多个下游任务中;在评估性能时尽可能保持超参数不变;确保报告最佳实践的结果,包括多次试验的均值与标准差。

参考链接:https://syncedreview.com/2021/03/03/google-study-shows-transformer-modifications-fail-to-transfer-across-implementations-and-applications/

建新·见智 —— 2021亚马逊云科技 AI 在线大会

4月22日 14:00 - 18:00

大会包括主题演讲和六大分会场。内容涵盖亚马逊机器学习实践揭秘、人工智能赋能企业数字化转型、大规模机器学习实现之道、AI 服务助力互联网快速创新、开源开放与前沿趋势、合作共赢的智能生态等诸多话题。

亚马逊云科技技术专家以及各个行业合作伙伴将现身说法,讲解 AI/ML 在实现组织高效运行过程中的巨大作用。每个热爱技术创新的 AI/ML 的爱好者及实践者都不容错过。

©THEEND

转载请联系本公众号获得授权